编辑|+0

2025 年即将画上句号,回望这一年的视频生成领域,用「突飞猛进」来形容毫不为过,甚至可以说,视频内容创作的范式正在悄然发生改变。

9 月,OpenAI 发布的 Sora 2 凭借「客串(Cameo)」功能,打破了困扰行业已久的「角色一致性」瓶颈,首创的「角色扮演功能」玩法让 AI 视频从充满不确定性的「盲盒抽卡」进化为可控的「导演游戏」。

与此同时,商业落地的速度快得惊人:在 B 端,大量 AI 短剧、漫剧上线,制作成本大幅降低;在 C 端,社交平台上不仅有「粘土滤镜」这样的爆款特效,更有大量博主开始常态化使用 AI 制作剧情短片。

然而,面对这些顶尖技术,普通用户的心情往往是「又爱又恨」。爱的是,各家 SOTA 模型生成的画面在光影质感与物理规律上已臻化境,甚至让人恍惚感叹「现实与虚拟的界限已然消失」;恨的是,体验的门槛依旧存在,要么是高不可攀的内测资格,要么是每月不菲的订阅账单。

前段时间,惊喜降临。阿里千问 APP 接入了 Wan 2.5(万相 2.5),让我们感受到了移动端创作的自由与畅快,这种在手机上免费生成「有声视频」的体验,确实很香。在权威大模型评测集 LMArena 上,万相 2.5 的图生视频能力曾位居国内第一。

而这份惊喜在年底迎来了重磅加码。12 月 16 日,阿里趁热打铁,正式发布了新一代万相 2.6 系列模型。如果说 2.5 版本是帮大家推开了视频创作的门,那么此次面向专业影视制作和图像创作场景全面升级的 2.6 版本,则是把专业影棚搬到了每个人面前,人人都能当电影主角或是导演。

体验入口:https://tongyi.aliyun.com/wan/generate/video/starring-roles?model=wan2.6

先看一段官方提供的视频,电影质感爆棚。

此次发布的万相 2.6 系列涵盖文生视频、图生视频和参考生视频,图像生成和文生图共 5 款模型,是目前全球功能覆盖最全面的视频生成模型家族之一。它是国内首个具备声画一致性角色定制能力的模型,这意味着你不仅能通过「角色参考」固定住视频中人或物的 IP 形象,还能参考输入视频中的音色,实现从画面到声音的完美复刻,无论是单人独白还是双人对手戏都能轻松拿捏。

更重要的是,此次发布的版本进一步提升了画质、音效和指令遵循能力,单次视频生成时长实现了国内最高的 15 秒(参考生视频为 10 秒),还带来了「分镜控制」功能,能自动拆解并实现多镜头切换等专业任务,让 AI 不再只是生成零碎的片段,而是开始懂得构建完整的故事线。目前,万相 2.6 已同步上线阿里云百炼和万相官网,企业用户可直接调用 API,千问 APP 也将于近期上线该模型。

简单来说,阿里这次不仅把画质拉满了,更是把摄影师、灯光师、动作指导和录音师打包塞进了你的手机和云端。

为了验证万相 2.6 是否真的这么厉害,我们决定不玩虚的,直接上手实测。

多角色声画同步的极限挑战

AI 视频最难的是什么?不是生成绚丽的画面,而是在动态变化中保持「保真」与「一致」。

大家应该都还记得 Sora 2 发布时被疯传的「百变奥特曼」:山姆·奥特曼(Sam Altman)在各种场景下做炸鸡、吃炒饭,虽然动作离谱,但那张脸和神态却始终如一。现在,万相 2.6 成了全球唯二,国内首个具备这种「参考生视频」能力的模型。

这是面向专业影视创作的一次全面升级。全新的视频参考生成功能,允许将任意人或物设定为主角,不仅能一键完成单人、多人、人与物合拍的视频,还能在多镜头丝滑切换的过程中保持核心主体、场景布局和环境氛围的统一。

从技术层面解析,通义万相在模型结构上集成了多项创新技术,可对输入参考视频进行多模态联合建模与学习。它不仅能参考具有时序信息的主体情绪、姿态和多角度全面视觉特征,更能同时提取音色、语速等声学特征,在生成阶段作为参考条件控制,实现从视觉到听觉的全感官、全维度一致性迁移。

而「分镜控制」则面向专业叙事场景,模型通过高层语义理解,将用户简单的提示词转换为多分镜脚本,生成包含多个镜头的连贯叙事视频,确保全片在内容、节奏和氛围上的高一致性。

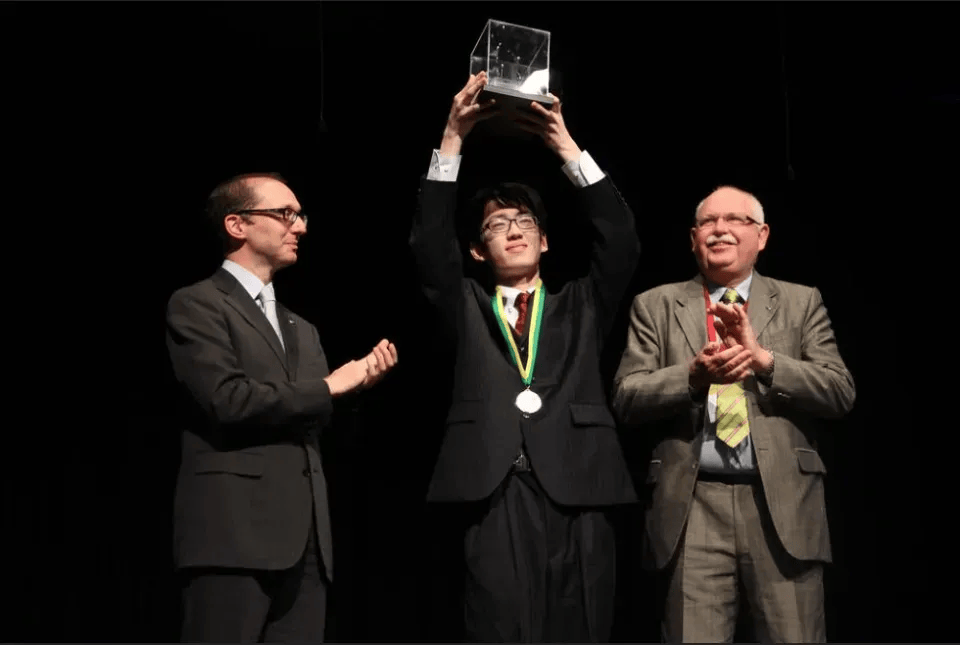

为了验证这一能力,我们直接上传了奥特曼、哈萨比斯和黄仁勋的过往视频片段作为参考素材。万相 2.6 能够精准提取视频中主体的形象特征、声音声线乃至惯用神态,并允许我们通过提示词将他们「传送」进全新的剧情中。

这一次,我们让这三位科技圈顶流在一个极具电影质感的平行宇宙里,来了一场关于 GPT-5.2 和 Gemini 3 的「现场互怼」。我们在对话框中输入设定台词和画面,分多次生成最后拼接画面。话不多说,直接来看正片:

英文版完美复刻了他们原本的声线与语调,效果令人咋舌。

为了让大家更直观地感受音频生成的实力,我们再看一个中文配音版,虽然语种跨越增加了难度,音频效果略逊色于英文版,但依然不仅形似,更是神似。

仔细观察三位主角的眉眼微表情、肢体语言乃至习惯性动作,还原度极高,几位「AI 演员」可以说是演技满满。Sam 从首日身体后仰的「跑分王」傲慢,到次日疯狂刷屏时的眼神闪烁、战术喝水,情绪转折丝滑流畅;Demis 那股从紧张防御到端着咖啡「贴脸开大」的戏谑笑意,简直灵魂附体。当然,最绝的还得是「皮衣教主」黄仁勋,那仰天大笑的一摊手,仿佛直接穿透屏幕在说:「争什么争?最后不都得靠我?」

为了方便大家复刻同款大片,官方贴心提供了两套核心提示词模板:

针对「参考生视频」,模型支持人物、萌宠或道具等任意类型主角(最多 3 个),并能完美复刻其外观、动态及音色。只需套用公式「@主角 + 动作 + 台词 + 场景」:通过 @ 符号精准引用参考素材,描述动作情绪、台词内容及所处环境即可。例如:在一个童话场景中,@A(参考视频为兔子)在草地玩耍,@B(参考视频为狗)在树下弹琴被苹果砸中,@A 开心地说:「你要变成科学家了!」

而在「多镜头叙事」方面,万相 2.6 能将原始输入构建为具备叙事张力的专业级多镜头段落。无论是启用智能多镜还是手动精控,推荐使用公式「总体描述 + 镜头序号 + 时间戳 + 分镜内容」。先概括故事主题与基调,再通过时间戳(如 [0-3 秒])划分结构,详细描述每个分镜的运镜与表演。例如:讲述一个重拾希望的短剧。第 1 镜头 [0-3 秒] 男孩看着信纸叹气;第 2 镜头 [3-5 秒] 特写眼角泪光;第 3 镜头 [5-10 秒] 场景切换,女孩微笑着走近安慰他。

当 AI 拥有了长叙事能力与「演技」

短视频时代,能不能火全看「梗」和「戏」,面向广告设计、短剧制作等专业场景,万相 2.6 展现出了惊人的潜力。通过输入连续提示词,它能生成一段完整叙事的短片,让人人都能当导演。下面我们测试一下它在细节把控和情绪表达上的「演技」。

为了验证模型在极端条件下的细节把控能力,我们尝试了一组高难度的特写镜头测试。

提示词:日式电影感,中近景:26 岁亚洲女性,黑色齐肩短发,清淡妆容,戴银边细框眼镜,穿着米白色宽松针织毛衣。她站在温馨昏黄的厨房里,手里端着一碗刚煮好的米线。特写镜头:碗中升腾起浓郁的白色蒸汽,热气瞬间扑在她的脸上,熏白了她的眼镜片,形成一层白雾。她微微一愣,透过模糊的镜片眨了眨眼,表情呆萌而治愈,背景是虚化的充满生活气息的冰箱和橱柜。

画面聚焦于一位刚下班的都市女性,她端着一碗热气腾腾的面条准备享用。令人惊叹的是,当热气上涌,水雾瞬间在她的眼镜镜片上凝结成一层细密而真实的白霜,视野的模糊与清晰交界处处理得极其自然,光影在水雾上的折射显得通透而生动。

在如此近距离的微距镜头审视下,人物皮肤细节展现出了电影级的高保真度:鼻翼两侧因热气熏蒸而泛起的微红、眼角极其细微的疲惫干纹,甚至是皮肤未施粉黛的细腻颗粒感和毛孔的「呼吸感」,都被完美捕捉和呈现,完全打破了以往 AI 生成人物常见的「塑料感」。

更绝妙的是人物的神态动作,当眼镜被蒙住的瞬间,她下意识地眯起眼睛,鼻头轻微皱缩,嘴角却又不自觉地挂着即将被美食治愈的满足笑意。

我们进一步尝试让「大宋第一狠人」苏轼穿越回来,录制「敬自己一杯」的 Vlog。

我们只需给模型设定一个首帧,输入提示词,模型就能快速完成分镜设计、角色演绎和画面配音。

提示词: (苏东坡举着酒杯,满脸通红,微醺状态) 第三杯!敬我的「大宋穷游指南」!皇帝把我贬到黄州,我发明了东坡肉;把我贬到惠州,我日啖荔枝三百颗;最后把我扔到海南岛(当时那是未开化之地),以为我会哭死?不好意思,我发现那边的生蚝真的太好吃了,还写信让儿子别告诉别人,怕朝廷那帮人跑来跟我抢。把流放活成《舌尖上的中国》,就问你服不服!喝!

来看看效果如何:

可以看到,视频不仅高度还原了我们设定的视觉风格,更在细节上经得起推敲:声画同步率极高,面部微表情随着台词层层递进。模型展现出了类似专业导演的运镜意识,通过推拉摇移和景深变化有效掌控了叙事节奏。视频中的苏轼全程以一种举重若轻的姿态讲述跌宕人生,既重现了「一蓑烟雨任平生」的豪迈豁达,又精准拿捏了「微醺吐槽」时的诙谐与松弛,感染力十足。

不容忽视的平面「基本功」

在大家的目光都被视频生成的「演技」吸引时,万相 2.6 在静态图像生成领域也悄然完成了版本迭代。对于一个多模态大模型而言,高质量的平面图像生成能力依然是其重要的「基本功」。

此次 2.6 版本的图像生成能力升级,主要体现在对画面细节的控制力和实用场景的覆盖,可以说是在「高美学」与「强可控」上同时迈出了一大步。

在基础的文生图方面,新模型实现了对艺术风格的「灵魂捕捉」。从提供的测试案例来看,模型对「肌理、色彩、笔触」等细节的刻画更为到位。无论是需要特定笔触感的东方水墨、拉斐尔艺术风格,还是偏向现代设计的数字插图、毛毡卡通风格,模型都能精准还原。更有趣的是它的「风格融合」能力,比如将「印象派」与「涂鸦」结合,模型能处理得过渡平滑且自然,创作出独具一格的视觉作品。

针对容易「翻车」的人物写实照片,2.6 版本综合优化了构图与光影,在一定程度上削弱了以往常见的「AI 塑料感」。实测中,人物神态更加自然,肤质真实感大幅提升,即便是复杂的环境情绪摄影,也能呈现出极具表现力的光影细节。

更具实用价值的是其在复杂排版和精准控制方面的提升。新版本改善了在图片中生成中英文文本的能力,这意味着制作带文字的海报、带有数据信息的图表变得更加直接。同时,模型不仅涵盖了广泛的历史文化 IP 元素,还新增了诸如「图文混排输出」和「多图融合生成」等功能,能够依据逻辑创作出具有叙事性的绘本或复杂的商品组合场景。

对于有特定需求的设计或商业场景,万相 2.6 提供了更细致的控制选项。例如,在需要保持商品或角色形象统一时,它提供了商用级的一致性保持能力;在调整画面氛围时,用户可以更精确地控制镜头的远近视角和光影效果。

提示词:给这个男生和狗拍一张写真,男生搂着这只狗,人和狗都很开心,摄影棚柔和灯光,蓝色纹理背景。

如果说视频生成是在探索 AI 动态表达的上限,那么图像生成板块的更新,则是在夯实 AI 平面创作的地基,提供了一套更为稳健、多样的工具集。目前,万相模型家族已支持文生图、图像编辑、文生视频、图生视频、人声生视频、动作生成、角色扮演及通用视频编辑等 10 多种视觉创作能力,已广泛应用于 AI 漫剧、广告设计和短视频创作等领域。

结语

万相 2.6 的发布,某种程度上标志着 AI 视频生成正式告别了单纯的「抽卡」时代,迈向了精准可控的电影级创作新阶段。

过去,我们惊叹于 AI 的画质,却苦恼于它的不可控。而现在,万相 2.6 用国内首创的角色扮演功能让「演员」听话懂戏,不仅能锁住容貌,更能演绎情绪;用智能分镜控制让叙事有了逻辑,从单点画面进化为连贯的故事篇章。它将曾经昂贵的影视工业特权,折叠进了手机和云端,彻底消除了技术对创意的阻隔。

当灯光、摄影、演员和剪辑都听命于你的指尖,技术不再是门槛。无论是想做一部「赛博大片」,还是只想发一条朋友圈恶搞 Vlog,都能找到顺手的工具。

门槛已经塌陷,工具就在手边。从此刻起,你的想象力,就是你的生产力。

体验链接:

万相官网:https://tongyi.aliyun.com/wan/阿里云百炼 API:https://bailian.console.aliyun.com/?tab=model#/model-market/all?providers=wan

文中视频链接:https://mp.weixin.qq.com/s/tgVN9ByxXn5NKDX8bArcgw

京公网安备 11011402013531号

京公网安备 11011402013531号