这项由蚂蚁集团和上海交通大学的张子引、廖子涵、俞航、狄鹏、王睿等研究人员联合完成的研究发表于2025年10月,论文编号为arXiv:2510.02294v1。有兴趣深入了解的读者可以通过该编号查询完整论文。

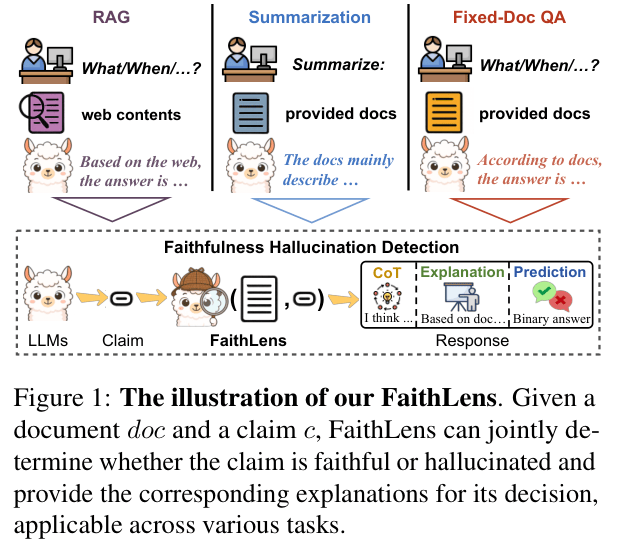

说到训练人工智能模型,很多人可能会想到那些需要海量数据和巨额资金投入的项目。不过,蚂蚁集团的这项研究却打破了这种刻板印象,证明了有时候"巧干"比"蛮干"更有效。他们开发出一套名为F2LLM的文本理解模型,仅用600万条开源数据就达到了与那些使用数亿条数据的顶级模型相当的性能水平。

F2LLM的全称是"Foundation to Feature Large Language Models",这个名字听起来很复杂,但实际上它的核心理念很简单:直接从基础的大语言模型出发,通过精心设计的训练方式,让它具备出色的文本理解和匹配能力。就像一个天资聪颖的学生,不需要题海战术,只需要精选的题目和正确的学习方法,就能在考试中取得优异成绩。

研究团队发布了三个不同规模的模型版本:0.6B、1.7B和4B参数版本。在权威的MTEB英文评测榜单上,F2LLM-4B在同等规模模型中排名第2,整体排名第7;而F2LLM-1.7B更是在1B-2B规模的模型中夺得头名。这样的成绩让人印象深刻,特别是考虑到它们使用的训练数据量相对较少。

传统的顶级文本理解模型通常需要经历复杂的多阶段训练过程,先用数十亿条弱监督数据进行预训练,然后再用高质量数据进行精调。这个过程不仅耗时耗力,还需要大量的合成数据,成本高昂。而F2LLM采用了一种更直接的方法:跳过预训练阶段,直接用精心筛选的600万条真实数据进行单阶段训练。这就像是跳过了大量的基础练习,直接进入核心训练阶段。

更重要的是,研究团队将整个训练过程完全开源,包括模型权重、训练数据和训练代码。这种透明度在当前的AI研究领域并不多见,为其他研究者提供了一个可复现、成本友好的基准线。

一、精心烹制的数据"食谱"

在AI模型训练中,数据就像烹饪时的食材,质量好坏直接影响最终成品。F2LLM的成功很大程度上归功于研究团队对训练数据的精心挑选和处理。

他们收集了总计约600万条训练样本,其中包括490万条检索任务样本、20万条分类任务样本和80万条聚类任务样本。这些数据全部来自开源的非合成数据集,就像是从各个优质农场精选出来的新鲜食材,而不是工厂批量生产的加工品。

为了统一处理不同类型的任务,研究团队设计了一种通用的数据格式:每个训练样本都包含一个查询、一个正相关文档和若干个负相关文档。这就像是为不同菜系设计了统一的烹饪流程,让原本复杂多样的数据处理变得条理清晰。

在检索任务的数据准备中,研究团队采用了一种叫做"基于边际的自适应难负样本挖掘"的技术。这个名字听起来很复杂,但实际上就像是为学生选择练习题时的策略:不选太简单的(学生一看就会的),也不选太难的(完全超出理解范围的),而是选择那些稍有挑战性的题目,这样才能有效提高学习效果。

具体来说,他们使用Qwen3-Embedding-0.6B模型来评估文档的相关性,然后排除得分过高的前5个文档(避免假负例),同时过滤掉得分过低或与正文档得分差异过大的文档,最终为每个查询选择24个高质量的负样本。这种精挑细选的过程确保了训练数据的质量和有效性。

对于自然语言推理任务,研究团队只保留至少有一个蕴含假设的前提作为查询,并从蕴含的假设中随机选择一个作为正样本。如果查询还配有中性或矛盾的假设,就将它们作为难负样本。对于文本相似度任务,他们遵循相关研究的做法,从相似度得分至少为4的句子对中构建查询-正样本对。

在分类和聚类任务中,数据处理相对简单一些。对于二分类任务,研究团队将每个输入文本作为查询,其标签文本作为正文档,其他类别的标签文本作为负样本。对于多类分类和聚类任务,他们为每个查询从同一类别或簇中随机选择一个样本作为正文档,从其他类别中选择24个样本作为负样本。

二、巧妙的训练"烹饪法"

有了精心准备的数据"食材",接下来就是如何"烹饪"出美味的模型了。F2LLM的训练过程就像是一位经验丰富的厨师,知道如何合理搭配不同的调料和火候。

F2LLM采用了基于Qwen3模型的架构作为基础,这相当于选择了一个优质的"炉灶"。研究团队直接在这个基础上进行对比学习的精调,而不需要进行大规模的弱监督预训练,这就像是直接用高级炉灶烹饪,而不需要先烧柴生火的准备过程。

训练过程中,研究团队使用了两种损失函数:难负样本损失和批内损失。难负样本损失确保模型能够区分查询与其对应的正文档和精心挑选的负文档;而批内损失则让模型学会在同一批次的所有文档中找到最相关的那一个。这两种损失函数的结合使用,就像是在烹饪中同时注意火候和调味,确保最终成品的质量。

特别值得注意的是,研究团队实现了一个自定义的多任务数据加载器,确保每个微批次中的样本都来自同一个数据源。这种设计让不同类型的任务能够和谐共存,就像在同一个厨房里同时准备不同菜系的料理,既保持各自的特色,又不相互干扰。

在每个训练步骤中,每个GPU上的数据加载器会根据数据源的大小按比例采样,确保所有数据集都能完成一轮训练再开始第二轮迭代。对于检索和聚类数据集,系统会从24个负样本池中随机选择7个负样本进行训练;而对于分类数据集,则只使用一个负样本。

训练超参数的设置也很有讲究。不同规模的模型使用不同的学习率:0.6B模型使用1e-5,1.7B模型使用9e-6,4B模型使用8e-6。全局批次大小统一设置为512,但使用的GPU数量和微批次大小根据模型规模有所调整。训练进行2个周期,使用500步的预热期,并采用余弦学习率衰减策略。

为了提高训练效率和减少内存使用,研究团队启用了ZeRO stage 2、Flash Attention 2和梯度检查点等优化技术。最大输入长度设置为1024个token,这些技术细节的精心安排确保了训练过程的稳定性和效率。

三、令人印象深刻的"出餐"效果

经过精心的数据准备和训练过程,F2LLM交出了一份令人满意的"答卷"。在权威的MTEB评测中,这个仅用600万数据训练的模型展现出了与那些使用数亿数据的顶级模型相媲美的性能。

F2LLM-4B在MTEB英文排行榜上取得了令人瞩目的成绩。在大约4B参数规模的模型中,它排名第2,在整体排名中位列第7。更令人印象深刻的是,F2LLM-1.7B在1B-2B规模的模型中夺得头名,而F2LLM-0.6B在小于1B参数的模型中排名第2。

这样的成绩特别有意义,因为排在它们前面的模型要么是闭源的商业模型,要么使用了数百倍于F2LLM的训练数据量。这就像是在马拉松比赛中,一个轻装上阵的选手跑出了与那些装备精良、训练充分的专业选手相当的成绩。

在具体的任务表现上,F2LLM在聚类任务中表现尤为出色。F2LLM-4B在聚类任务上得分68.54,创下了所有模型的新纪录。这个成绩说明了模型在理解和组织相似内容方面的卓越能力,就像是一个出色的图书管理员,能够准确地将书籍按照主题进行分类整理。

在分类任务上,F2LLM的表现同样令人满意。F2LLM-4B在分类任务上得分91.68,显示出模型在理解文本内容并准确判断其类别方面的强大能力。这种能力在实际应用中非常有价值,比如自动识别邮件类型、新闻分类或者情感分析等场景。

在检索任务上,虽然F2LLM的表现相对其他顶级模型稍逊一筹,但考虑到它使用的训练数据量相对较少,这样的表现仍然值得称赞。F2LLM-4B在检索任务上的得分为59.63,虽然不是最高,但已经达到了实用级别的性能。

在重排序任务上,F2LLM-4B得分50.05,在语义相似度任务上得分84.20,在文本摘要任务上得分33.19。这些成绩虽然不是在所有任务上都达到最高水平,但整体平均分73.67的成绩足以证明模型的综合实力和实用价值。

更重要的是,F2LLM实现了在模型规模、训练数据量和性能之间的良好平衡。研究团队的分析显示,在训练数据量与性能的关系图中,F2LLM位于一个非常有利的位置:用相对较少的数据获得了相对较高的性能,这种效率优势在实际应用中具有重要意义。

四、开源共享的"菜谱"

F2LLM项目最值得称赞的地方之一就是其完全开源的理念。研究团队不仅发布了训练好的模型权重,还公开了完整的训练数据和训练代码,这在当前的AI研究环境中显得格外珍贵。

这种开源精神就像是一位著名厨师不仅分享了自己的招牌菜,还毫无保留地公开了完整的菜谱、食材清单和烹饪技巧。这种做法让其他研究者能够完全复现实验结果,也为后续的改进和创新提供了坚实的基础。

开源的训练数据包括了详细的数据统计信息,显示了各个数据集的规模、平均查询长度、语料库大小等关键信息。比如,在检索数据中,PAQ数据集包含了938,771个查询和2,492,657个文档,平均查询长度为30个token,平均文档长度为145个token。这些详细信息让其他研究者能够更好地理解和使用这些数据。

在分类和聚类数据方面,数据集涵盖了从Amazon产品评论分类到科学论文聚类的各种任务。比如,Amazon情感分类数据包含100,000个查询,每个查询平均长度为115个token;而ArXiv论文聚类数据包含83,476个查询,对应299,733个文档,平均查询长度为245个token。

研究团队还提供了详细的训练指令模板,展示了如何为不同类型的任务构建统一的输入格式。这些指令模板就像是标准化的操作程序,确保不同类型的数据能够以一致的方式被模型理解和处理。

通过GitHub和Hugging Face平台,研究社区可以轻松获取F2LLM的所有资源。模型可以直接下载使用,训练代码可以用于复现实验或进行改进,训练数据可以用于进一步的研究。这种完全透明的做法为构建更好的文本理解模型提供了宝贵的资源和经验。

五、未来应用的广阔前景

F2LLM的成功不仅在于其技术成就,更在于它为实际应用开辟的可能性。由于模型在保持高性能的同时大大降低了训练成本,这使得更多的组织和研究者能够开发和部署高质量的文本理解系统。

在搜索引擎优化方面,F2LLM可以帮助改进文档检索的准确性。当用户输入查询时,模型能够更好地理解查询意图,并从庞大的文档库中找到最相关的内容。这种能力对于企业内部知识管理系统、学术文献检索或者电商产品搜索都具有重要价值。

在智能客服系统中,F2LLM的文本理解能力可以帮助更准确地识别用户问题的类型和意图。系统可以将用户的问题快速分类,然后匹配到最合适的处理方案或者人工客服,大大提高服务效率和用户满意度。

在内容推荐领域,F2LLM的聚类能力可以帮助平台更好地理解用户兴趣和内容特征。通过分析用户历史行为和内容特征,系统可以更精准地推荐用户可能感兴趣的内容,无论是新闻文章、视频内容还是商品信息。

对于中小型企业和创业公司来说,F2LLM提供了一个成本效益比极高的解决方案。他们不需要投入巨额资金来收集和标注海量数据,也不需要部署庞大的计算资源进行模型训练,就能获得接近顶级水平的文本理解能力。

在教育领域,F2LLM可以应用于智能批改系统、个性化学习推荐或者学术论文相似度检测等场景。其出色的聚类和分类能力可以帮助教师更好地组织教学内容,为学生提供更精准的学习建议。

研究团队的这项工作也为AI民主化做出了重要贡献。通过证明高质量的AI模型不一定需要海量资源,他们为更多的研究者和开发者打开了参与AI发展的大门。这种技术普及效应可能会催生更多创新应用和商业模式。

说到底,F2LLM的价值不仅在于它优异的技术指标,更在于它展现了一种更加高效和可持续的AI发展路径。在追求模型性能的同时,研究团队没有忘记资源效率和技术普及的重要性。这种平衡发展的理念值得整个AI研究社区学习和借鉴。

从某种程度上说,F2LLM的成功证明了"巧干胜过蛮干"这个朴素道理在AI领域同样适用。通过精心的数据选择、巧妙的训练策略和开源的分享精神,研究团队用相对有限的资源创造了令人印象深刻的成果。这种成功模式不仅为当前的文本理解任务提供了优秀的解决方案,也为未来的AI研究指明了一个更加理性和可持续的发展方向。对于那些希望在AI领域有所建树但资源有限的团队来说,F2LLM无疑是一个值得深入研究和学习的典型案例。

Q&A

Q1:F2LLM模型有什么特别之处,为什么只用600万数据就能达到顶级性能?

A:F2LLM的特别之处在于采用了精心设计的单阶段训练策略和高质量的数据筛选方法。研究团队跳过了传统的大规模预训练阶段,直接使用精选的600万条真实数据进行训练,并采用了"基于边际的自适应难负样本挖掘"技术来提高训练效率。这就像是选择最有效的练习题而不是盲目刷题,通过质量而非数量取胜。

Q2:F2LLM在MTEB评测中的具体表现如何?

A:F2LLM在MTEB评测中表现出色。F2LLM-4B在同等规模模型中排名第2,整体排名第7;F2LLM-1.7B在1B-2B规模模型中排名第1;F2LLM-0.6B在小于1B参数模型中排名第2。特别值得一提的是,F2LLM-4B在聚类任务上得分68.54,创下了所有模型的新纪录,显示出模型在内容理解和组织方面的卓越能力。

Q3:普通开发者如何使用F2LLM?有什么获取途径?

A:F2LLM完全开源,开发者可以通过GitHub(https://github.com/codefuse-ai/CodeFuse-Embeddings)和Hugging Face平台获取模型权重、训练数据和完整的训练代码。研究团队提供了三个不同规模的模型版本(0.6B、1.7B、4B),开发者可以根据自己的计算资源和应用需求选择合适的版本。所有资源都可以免费获取和使用。

京公网安备 11011402013531号

京公网安备 11011402013531号