内容网络信息汇编整理。

责编| 柒 排版| 拾零

第 9440篇深度好文:5815字 | 15 分钟阅读

商业趋势

笔记君说:

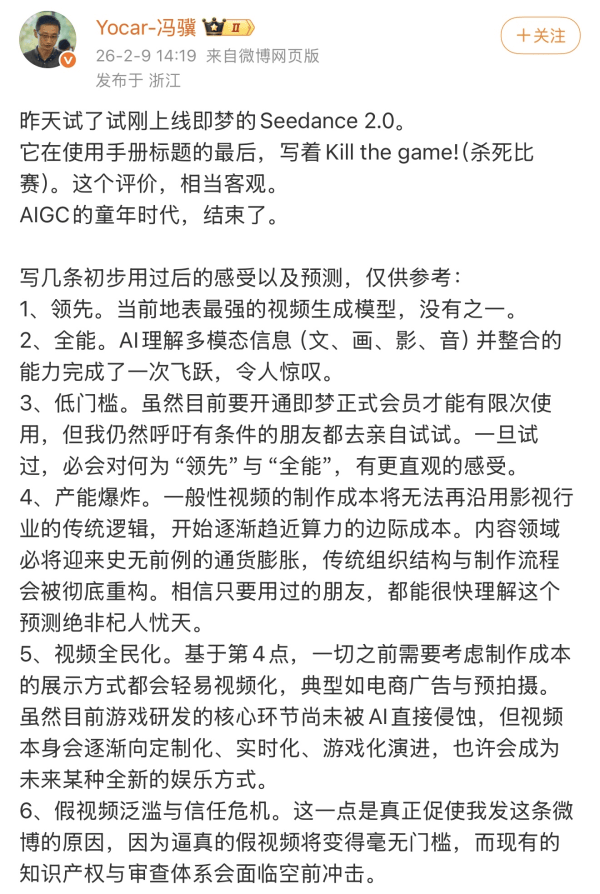

最近圈子里被一个东西刷了屏——字节跳动悄悄上线的新一代视频生成模型Seedance2.0,也就是大家说的即梦2.0。

官方没大张旗鼓官宣,就小范围测了测,结果直接让AI视频圈炸了锅。有人惊呼“不需要人类了,AI制作AI看”,有媒体直接说“AI视频第一阶段的比赛,结束了”,就连开发者都在文档里直接写下“Kill the game(杀死比赛)”。

看了各个博主的实测和官方信息,越看越心惊:这根本不是一次普通的模型迭代,而是直接把AI视频拽进了“流水线时代”。

以前我们觉得AI做视频还只是“凑活看”,现在它已经能当半个专业导演了,传统影视、短剧、动漫的制作逻辑,怕是要被彻底改写。

这个Seedance2.0到底有多牛,它又会给整个视频行业带来什么改变。

AI视频赛道的军备竞赛,自从Sora出来后就没停过,但大家折腾来折腾去,始终绕不开几个痛点:要么生成靠运气“抽卡”,要么画面崩、人物脸忽大忽小,要么得费劲吧啦教AI怎么运镜、怎么切分镜,普通人根本玩不转。

但字节的Seedance2.0,直接把这些痛点全给抹平了。

它让AI视频从“拼技术、凑效果”,变成了“随手做、稳出片”,甚至让普通人不用懂任何拍摄技巧,就能做出堪比专业导演的视频内容。

更关键的是,它让AI视频的生产,真正实现了“创意直达结果”——你不用再想“这个AI能不能做到”,只需要想“我要讲一个什么故事”。

这不仅是一次模型的升级,更是视频创作行业的一次底层革命。

一、这届AI导演,

比真人还懂怎么拍视频

说实话,第一次看Seedance2.0的生成效果,第一反应是“这真的是AI做的?”。它最牛的地方,不是多了什么花里胡哨的功能,而是把“做视频”这件事的门槛,降到了地板上,同时把效果拉到了天花板。

简单说,它现在就是个“全能AI导演”,你只需要告诉它“演什么”,它自己就知道“怎么拍”。核心的硬本事,就这么几个,每一个都戳中了过去AI视频的痛点:

1.万物都能“甩给它”当参考

以前做AI视频,你得绞尽脑汁写一大段提示词,描述人物长什么样、动作是什么、场景啥氛围,写不好AI就给你瞎做。

现在不用了,直接用“@”的方式,甩一张图片、一段视频甚至音频给它,它就能精准复刻人物、动作、特效,指哪打哪。

而且它最多能同时接9张图、3段视频、3段音频,相当于给你一个“导演工具箱”,想要什么风格、什么动作,直接塞给它就行。

2.自动分镜+运镜,不用教AI怎么拍

这是最让专业导演破防的一点。过去用AI做视频,你得精确告诉它“镜头从左向右移”“先全景再特写”,稍微复杂点,AI就迷糊。

但Seedance2.0能根据你说的故事,自己规划分镜和运镜。比如你说“黑衣男子快速逃亡,后面有人追,撞倒水果摊再爬起来跑”,它会自动用侧面跟拍、快切镜头,做出堪比真人导演的效果,完全不用你操心拍摄手法。

3.音画同步拉满,表情动作全在线

以前AI做的视频,要么口型对不上声音,要么表情和语气脱节,看着特别尬。Seedance2.0生成视频时,能同步做音效、配乐,角色说话嘴型严丝合缝,激动时挑眉、无奈时叹气,情绪和动作能完美匹配。

甚至你只传一张人物照片,它连服装纹理、肢体的重力感都能模拟,不会出现配件飘走、衣服纹理闪烁的情况。

4.多镜头叙事不崩,角色从头到尾是同一个人

这是做长视频的关键。过去的AI,拍几个镜头就把人物拍“变脸”了,场景光影也忽明忽暗。

但Seedance2.0能在多个镜头切换中,牢牢维持角色和场景的一致性:从室外走到室内,光线会跟着变,衣服的褶皱、阴影也会同步调整,全程人物脸不变、衣着不变,再也不会出现“拍着拍着主角换了个人”的尴尬。

除此之外,还有两个超实在的提升:

一是单次能直接生成15秒视频,这是目前AI视频里最长的;

二是生成成功率直接干到90%以上,彻底告别了以前靠运气“抽卡”的时代——以前做5次可能只有1次能用,现在随便做,基本一次出片,不用当“提示词工程师”反复抠细节。

二、实测:它不止会做视频,

还开始“理解”世界了

不少博主已经抢先上手,从简单的画面复刻,到复杂的特效打斗,再到连贯的短剧创作,层层递进的测试,让我们看到了一个近乎“全能”的AI导演。

1.基础题:樱花树下的邂逅,细节见真章

第一个测试,是一个充满电影感的经典场景:樱花树下,女孩扭头看向猫,花瓣飘落,微风吹过她的头发,最后女孩摸了摸猫的头。

樱花、女孩、猫视频|图片即梦 Seedance2.0

这个提示词看似简单,却是检验AI视频能力的“基础题”,非常考验细节处理:花瓣的飘落轨迹要自然,不能是杂乱无章的;猫的毛发要有质感,不能像塑料玩具;风吹头发的动态要连贯,并且要和花瓣的方向一致,体现出“风”这个物理条件。

Seedance 2.0的表现让人眼前一亮。生成的画面里,花瓣飘落有明显的层次感,近处的花瓣大、远处的小,速度也有差异,非常真实。猫用头蹭了蹭女孩的手,耳朵还会偶尔动一下,细节拉满。

最关键的是,头发的飘动和花瓣的方向完全一致,这说明模型真正“理解”了“风”的存在,而不是简单地把“风吹头发”和“花瓣飘落”两个元素生硬地拼在一起。整体的色调和光影处理也很有电影感,不是那种一眼就能看出是AI生成的过饱和画面。

更让人惊喜的是成功率。同样的提示词,放在以前,可能需要反复“抽卡”十几次才能撞上一次满意的效果。但这次,博主一次就成功了。这种“指哪打哪”的精准度,正是Seedance 2.0强大之处的直接体现。

2.进阶题:动漫特效打斗,节奏与逻辑并存

在基础题上拿到高分后,博主开始加大难度,尝试制作一个15秒的动漫特效画面。

提示词信息量很大:少年主角在战斗中被击倒,绝境中觉醒隐藏力量,身体周围爆发金色气场,头发变色竖起,眼瞳变为异色,随后以超高速冲向敌人,释放一记巨大的能量斩击,斩击波横切整个天空。

这个场景包含了情绪转变、特效爆发、动作衔接、画面节奏等多个维度的要求,是对AI视频能力的一次全面考验。以前的模型处理这种复杂场景,很容易出现角色变形、特效和动作不同步、画面节奏混乱等问题。

动漫特效片段视频|图片即梦 Seedance2.0

但Seedance 2.0交上了一份近乎完美的答卷。生成的视频节奏感把控得非常好:

从被击倒的沮丧,再到气场爆发的愤怒,情绪转折明确。金色气场的爆发和头发变色是同步发生的,有明显的因果逻辑,而不是杂乱无章的特效堆砌。最后的能量斩击也有一个从蓄力到释放的完整过程,斩击波划过天空的画面确实有燃起来的感觉。

看到这个结果,博主直言:“这个效果,已经可以直接放到动漫短视频里用了。”这不仅是对画面质量的肯定,更是对其叙事逻辑和情绪表达能力的高度认可。

3.挑战题:60秒AI动漫短剧,流水线创作的开端

如果说前两个测试还只是“小试牛刀”,那么博主接下来的尝试就非常大胆了:直接用Seedance 2.0做一个60秒的AI动漫短剧。

要知道,Seedance 2.0目前最长只支持15秒的视频生成,60秒意味着需要将4个15秒的片段拼接起来。

这对模型的能力提出了更高的要求:多个镜头之间要能流畅衔接,角色形象要保持一致,剧情推进要有节奏。

放在以前,这基本上需要借助专业的视频Agent工具,把任务拆解成多个步骤,一个镜头一个镜头地生成,再人工剪辑拼接,整个流程下来可能需要大半天时间。

但借助Seedance 2.0可以方便引用多张图片的功能,博主的操作变得异常简单。他只是分别四次输入了四个不同镜头的提示词和一段相同的剧情描述,然后用剪映把生成的四个片段拼接在一起,就完成了整个作品。

动漫短剧片段|图片即梦 Seedance2.0+剪映拼接

最终的成片效果超出预期:镜头之间的过渡自然连贯,角色从头到尾没有“变脸”,情节推进的节奏也很不错。

虽然因为提示词是随意写的,存在一些小瑕疵,但整个过程只花了不到15分钟,而且中途没有重新“抽卡”一次。这种效率和效果,甚至比某些专门做AI视频的Agent工具还要好。

这次成功的尝试,让博主深刻感受到:Seedance 2.0已经让AI长篇视频生产,特别是真人AI长篇视频生产,真正进入了“流水线时代”。一张人物设计图,一段表演文本,一步就能做出最终的视频,创作的门槛被大大降低。

通过这些案例测试,我们可以清晰地看到Seedance 2.0展现出的“世界模型雏形”:它不再是简单的“画面拼接”,而是开始“理解”这个世界的物理规律、因果关系和情绪表达。

当然,Seedance 2.0也并非完美无缺。目前来看,它最大的遗憾就是单次生成的最长时长只有15秒,虽然这已经是目前AI视频的天花板,但如果想做更长的内容,还是需要进行拼接,多少会影响创作体验。

此外,它对一些具体的知名IP、人物的还原会有偏差,这大概率是为了规避版权问题。平台目前对名人、知名IP的视频生成也有审核限制,一些特定的内容还无法生成。

三、行业底层逻辑改写:

三大行业一夜变天

如果说功能强大只是“产品牛”,那Seedance2.0真正的杀伤力,是它直接改写了整个视频行业的底层逻辑——成本大幅下降,效率指数级提升。

1.漫剧Agent:中间层的价值,一夜被稀释

在AI视频赛道,漫剧Agent曾是为数不多跑通商业模式的香饽饽,算是行业里的“中间商”。

这帮玩家的赚钱逻辑特别朴素:从模型厂商那里谈下低价API,靠自己的技术拆解视频制作工作流、优化生成流程,再把生成服务转手卖给用户,赚个差价。

比如一个视频市场价50块,他们拿30块的成本,卖45块,靠信息差和流程优化吃中间的利润。说白了,他们的核心价值,就是弥补早期AI模型能力的不足,做“模型和用户之间的桥梁”。

但Seedance 2.0一出来,这座桥直接就被拆了。

一方面,这个模型的能力太能打了:不用再费劲拆解工作流,普通人一句话、一张图就能直接出片,生成成功率90%以上,根本不需要Agent来做流程优化;另一方面,所有人都想抢着用Seedance 2.0,短期之内根本拿不到以前的低价折扣,中间商的差价空间被直接堵死。

开源证券的研报里说得很直白,国内AI视频赛道已经进入了类似2025年大语言模型的竞争状态,基础能力都到了高水准,后续拼的不是谁能做流程拆解,而是谁能把对Seedance 2.0的理解揉进产品里。

2.短剧:成本砍90%,产能迎来史诗级爆发

这两个行业现在正处于快速发展期,但传统制作模式的痛点早就藏不住了:拍一部短剧,演员、场地、摄像团队占了成本的大头,一个简单的短片从策划到成片,要跨部门协作,光时间成本就要数周甚至一两个月,产能始终上不去。

而Seedance 2.0直接把这些痛点全给解决了。它的多镜头叙事能力、角色一致性,刚好踩中了短剧漫剧的制作需求,不用找演员、不用租场地,一张人物设计图+一段表演文本,几分钟就能生成一段高质量的视频,传统制作的核心成本能直接砍掉90%以上。

更关键的是,制作周期的大幅缩短,让行业能做快速的A/B测试,用数据驱动内容迭代——这是传统拍摄流程想都不敢想的事。

当制作门槛被拉到地板,成本被砍到极致,这个行业的产能会迎来一次史诗级的爆发,整个产业链的规模也会跟着水涨船高。

说白了,短剧漫剧的竞争,从此不再是“谁能拿到更多拍摄资源”,而是“谁能想出更好的故事”。

3.传统影视/特效:上万倍的效率差,被降维打击到无力

如果说短剧漫剧是“被颠覆”,那传统影视制作,尤其是特效领域,就是被Seedance 2.0来了一记降维打击。

传统流程里,一个5秒钟的特效镜头,需要高级制作人员花近一个月的时间来做,不算其他环节,光人工成本就超过3万元;而用Seedance 2.0,同样效果的特效镜头,2分钟就能生成,成本还不到3块钱。

上万倍的效率提升,上万倍的成本下降——这已经不是“谁做得更快更好”的竞争,而是“你用冷兵器,我拿机关枪”的代差。

就连做一部常规的90分钟片子,成本变化都让人咋舌。以前用其他AI模型,因为生成成功率不到20%,理论成本1800块的片子,实际要反复生成,成本直接飙到1万块;而Seedance 2.0的可用率90%以上,实际成本直接降到2000多块,接近理论成本。

对传统影视人来说,最无奈的不是“AI做得比我好”,而是“AI做得又快又好,还花不了几个钱”。那些靠精湛的特效技术、多年的拍摄经验建立的竞争力,在这种极致的效率和成本面前,瞬间被稀释。

当然,院线电影的核心竞争力还有故事、审美和表演,但对于那些标准化的特效镜头、辅助镜头来说,AI的替代,已经是板上钉钉的事。

四、技术不再是壁垒,

真正的竞争才刚开始

有人实测Seedance 2.0后感慨:从前做视频先想“模型能不能做到”,现在只专注“我要讲什么故事”。这句话,正是对它最精准的评价,也宣告了AI视频第一阶段比赛的落幕。

第一阶段的竞争,拼的都是画面、动作、稳定性这些技术硬指标,而Seedance 2.0直接把这个阶段的天花板拉到了新高度,让技术本身不再是行业的竞争壁垒。

当AI视频生产实现民主化,人人都能做出电影级画面时,工具便彻底退到了幕后,像写字的笔一样,成为创作的背景,让创作者真正站到台前。

AI视频的第二阶段比赛已然开启,这一阶段,拼的不再是技术,而是创意、审美,是讲好故事的能力。毕竟创作从来不是技术问题,知道怎么用工具,远不如知道该创造什么重要。

未来,会用AI的人随处可见,但能讲出动人故事、拥有独特审美视角的创作者,永远稀缺。而这份稀缺,就是我们最核心、最不可替代的竞争力。

参考资料:

1.《即梦Seedance2.0视频模型"王者归来"之后|最新突发:模型太强以至禁止了真人人脸支持...》,Web3天空之城

2.《Seedance 2.0:AI视频第一阶段的比赛,结束了|AI上新》,极客公园

3.《Seedance 2.0爆火!黑神话冯骥称其为地表最强没有之一》,商学院

4.《实测Seedance 2.0:当AI成为导演,Sora 2被超越了?》,贝壳财经

*文章为作者独立观点,不代表笔记侠立场。

京公网安备 11011402013531号

京公网安备 11011402013531号