编辑|Panda

在数字世界里,AI 智能体正通过 MoltBook 这样社交网络进行语义协商并协同进化,而在物理世界中,具身智能也迎来了一次里程碑式的进展。

在原力灵机的实验室里,一台由 Hugging Face 开源的、3D 打印出来的 SO-101 机器臂正灵巧地将外形各异的物品放入指定的盒子中。这个动作看似简单,实则包含了极高频的视觉反馈、力度感知以及对复杂物理环境的直觉判断。

实际上,这种从「计算」到「直觉」的跨越,并非源于针对这个特定硬件的繁琐调优,而是受益于一套标准化的底层基建。

在 2 月 10 日的技术开发日上,原力灵机正式发布了开源具身原生框架 Dexbotic 2.0,并宣布了其与清华大学和无问芯穹支持的强化学习框架 RLinf 的战略合作

原力灵机合伙人汪天才将 Dexbotic 2.0 与 RLinf 的深度结合定义为具身智能行业的「PyTorch 时刻」。正如 PyTorch 通过标准化的张量计算与自动微分机制释放了深度学习的生产力,Dexbotic 2.0 与 RLinf 的联手试图在具身智能这个碎片化严重的赛道上,建立一套通用的底座和基础设施。

伴随这一框架升级和战略合作一同亮相的,还有全球首个具身原生大模型 DM0以及具身应用量产工作流 DFOL

这一整套全链路布局宣告了一个极具冲击力的断言。正如原力灵机 CEO 唐文斌在现场所说:「2026 年不是具身智能的元年,而是具身原生的元年。」这意味着具身智能正在告别「大模型外挂一双机械手」的初级阶段,正式进入感知、决策与控制高度协同的「具身原生」时代。

从端到端自动驾驶算法 PETR 的核心作者,到如今投身物理 AGI 的弄潮儿,汪天才如何理解具身智能的进化路径?Dexbotic 2.0 又将如何改变开发者与机器人的交互方式?且随我们的这篇专访报道一起,洞见基于具身原生的物理 AGI 的未来。

汪天才,原力灵机合伙人,原旷视科技高级研究员,在 CVPR、ICCV 、TPAMI 等国际顶会、顶刊累计发表论文 30 余篇,是端到端自动驾驶知名算法 PETR、通用端到端多目标追踪算法 MOTR 核心作者;截至目前,谷歌学术论文累积引用量 6000 以上

定义「具身原生」

物理 AGI 的进化逻辑

当今的多模态大模型已非常强大,掌握了编写代码和视觉推理等诸多能力,甚至有的还能根据手绘的草稿创建出完整的应用。然而,一旦进入物理世界,接入物理机器作为肢体后,这些强大的高智商模型却常表现得非常笨拙,甚至会让机器人做出一些蠢笨乃至危险的行为。也因此,现在的智能机器人往往是人类遥控的,难以自主地生活在真实世界的场景中。

原因不难理解,在这种「大模型大脑+机器肢体」的逻辑下,必然存在数字模型与物理世界的失配问题;此时,AI 智能体更像是被困于数字世界的旁观者,而不是物理世界的真正参与者。

要让具身智能真正完成这样的转变,成为物理世界的真正参与者,我们需要的是「具身原生」。

「具身原生(Embodied Native)」是由原力灵机首次提出的具身智能概念,其核心在于构建感知、决策与执行的高度闭环。更具体来说,具身原生包含数据原生、训练原生和框架原生:

数据原生:强调使用真实世界全要素数据与具身多模态数据。模型需要从 0 开始学习物理世界的交互逻辑,而非单纯继承互联网数据的预训练成果。训练原生:旨在让模型能够理解、影响并预测物理世界。模型在设计之初就立足于真实环境,使用真实世界的效果作为评价标准,其奖励(Reward)机制直接源自真机的运行反馈。框架原生:为模型提供底层的支撑能力,包括对多模态数据的深度支持、强大的记忆能力以及通用的动作(Action)执行能力。

同时,原力灵机还指出,「具身智能正在把智能从对世界的表征与解释推向对世界的介入与改变。」这就意味着模型必须走进复杂的物理空间,去承担真实的因果责任。

在虚拟的聊天框里,回复错误或许只是一行文字的偏差。但在现实世界中,模型的一次微小判断失误就可能引发碰撞、损坏或不可逆的硬件后果。具身原生框架 Dexbotic 2.0 的提出,正是为了应对物理世界的高熵与不确定性。

对于为何将此时定义为「具身智能的 PyTorch 时刻」,汪天才有着清晰的行业洞察:当前的机器人研发正处于高度碎片化的状态,开发者们往往需要耗费大量精力在数据格式适配、仿真器连接等底层工程上。而随着 Dexbotic 2.0 的到来及其与 RLinf 的深度结合,这些繁琐的碎片化工作可能都将成为过去时。他明确表示:Dexbotic 2.0 的定位是「具身算法研发的 Infra」

也就是说,原力灵机希望 Dexbotic 2.0 能像 PyTorch 一样,成为一个开放、统一、可扩展的基础设施。汪天才认为,这就像将行业内各种混乱的接口统一为 Type-C 标准。

原力灵机进一步强调,具身 Infra 直接决定了具身模型的迭代效率。在过去碎片化的环境下,开发者往往有超过一半的精力被迫消耗在适配不同的硬件接口、数据格式以及仿真环境上,这就像是在泥泞的土路上试图跑出法拉利的速度。Dexbotic 2.0 的价值,正是通过标准化的基建将开发者从这些繁琐的底层工程中解放出来,大大降低了试错成本,让模型迭代的飞轮能够以最小的摩擦力高速转动。

这种基础设施的标准化,是物理 AGI 实现规模化增长的前提。只有当底层框架变得确定且易用,开发者才能将精力集中在「算法与模型创新」这一核心目标上,推动具身智能从简单的展示品向真正的生产力工具进化。正如汪天才说的那样:「我们其实聚焦的就是降低用户的开发门槛,让开发者可以只聚焦到他想去做的事情。」

此外,汪天才还补充道,具身原生不仅关乎算法架构,还涉及多模态传感的深度融合。例如触觉与六维力信息,这些感知维度的引入会直接影响模型对于整个物理世界的建模能力。汪天才总结道:「这些信息都是非常非常重要的,它会影响你对于整个世界的建模。」这种全方位的原生设计,构成了通往物理 AGI 的核心基石。

Dexbotic 2.0

基于模块化的端到端具身原生框架

在具身智能开发者的工具箱里,长期存在着一种「既要又要」的焦虑:一方面,大家渴望模块化带来的灵活性,希望像换镜头一样随时升级感知模型或控制算法;另一方面,为了追求极致的反应速度和决策精度,行业又在集体涌向「端到端」范式。

Dexbotic 2.0 的出现,正是为了终结这种在模块化与端到端之间的长期摇摆。它在架构上维持了高度解耦的模块化设计,但底层的数据流却是纯正的端到端逻辑。

汪天才在采访中明确指出:「无论是记忆模块的设计,还是整体系统架构,我们都刻意避免采用类似 RAG 这样的显式检索机制。在我看来,那并不代表真正的智能。真正的智能应当发生在隐式空间中,更接近人脑的工作方式,模型不需要显示地打印出思考过程。」

可以说,Dexbotic 2.0 的使命就是让智能体直接从感知输入跨越到动作输出,实现感知、决策与执行的深度耦合

技术理念:对端到端范式的信仰与坚持

事实上,汪天才对于端到端范式的坚持堪称信仰,他也在采访回顾了自己职业生涯中的这份坚持:「从 2020 年开始相关研究时,我们最早做的是 MOTR,一个通用的多目标追踪算法。它并不局限于特定场景或赛道,而是面向更一般的问题设定。事实上,从那个阶段起,我们在认知上就已经非常坚定地认同端到端这一范式,这也是当初选择做 MOTR 的根本原因。从 MOTR 到 PETR(一个端到端自动驾驶算法),再到后续在具身智能和大模型方向上的探索,本质上始终是一条端到端的方法论路径。当前的多模态大模型同样是端到端的,这进一步强化了我们最初的判断。」

MOTR 与 PETR 架构示意图

2020 年,当时还在旷视科技的汪天才等人推出 MOTR 时,端到端多目标追踪仍属非主流路线,该团队在投稿与学术交流中面临较高的认知与说服成本,需要持续挑战以 ReID、IoU matching 等手工设计为主的既有范式。这甚至导致了一个非常有趣但又有些苦涩的经历:「MOTR 比 PETR 早将近两年完成,但这两篇论文最终几乎是同时被接收的。」

一个重要原因在于,到 PETR 阶段,整体的说服成本已经明显降低。汪天才解释说:「当时特斯拉已经在 2021 年年中发布了其 BEV 方案,我们的 PETR 工作是在 2021 年底推出的,是国内最早一批能够在理念上对标特斯拉、同时又采用不同技术路径的方案之一。在已有特斯拉工作的前提下,端到端 BEV 路线的合理性更容易被理解和接受。再加上 PETR 是开源工作的,因此并未像 MOTR 那样经历极高的认知阻力。」

「也正是从 MOTR 到 PETR 的这一过程,进一步坚定了我们持续推进端到端方法论的信念。」这位已经拥有超 6000 引用的研究者总结道,「后续我们开展了大量预研工作,例如 MemoryVLA,我更倾向于将其视为过去两三年 StreamPETR 工作在方法论上的自然延续。区别仅在于应用场景,一个面向自动驾驶,一个面向具身智能,但其背后的思想是通用的。」

MemoryVLA 架构示意图

汪天才在采访中也透露了他从纯模型研究转向具身智能的底层逻辑。他坦言,在数字世界单纯依靠模型是无法实现真正闭环的,「大模型一定要跟智能硬件结合」。这种对「闭环」的追求,正是他当初坚定选择具身这一赛道的根本原因。

现如今,Dexbotic 2.0 继续延续着汪天才在端到端范式上的坚持,并在架构层面上将其重塑为一套兼具模块化灵活性与端到端高性能的「具身原生」系统,其包含五大核心特性。

框架原生:服务于端到端的模块化

虽然追求端到端的整体表现,但 Dexbotic 2.0 在架构上选择了高度解耦的模块化设计。它将系统拆分为三个可以自由组合的模块,汪天才将其比作是机器人的「乐高系统」。

Vision Encoder(视觉编码):负责将摄像头画面编码成特征,已适配 CLIP、sigLIP、PE 等多种模型。LLM(认知规划):作为核心大脑,统一接收视觉特征与文字指令,支持 Qwen、StepFun 或 PaliGemma 等不同规模的模型。Action Expert(动作专家):将意图转化为物理轨迹,支持 Diffusion、Flow Matching 或 Autoregression 等多种生成路径。

对于这种看似矛盾的设计,汪天才解释道:「通过这种解耦设计,同一套系统可以在感知、认知和控制三个层面独立升级。虽然模块可以独立迭代,但它们最终在训练中会形成一个整体。」如此一来,可让模型直接学习从 728×728 高清视觉输入到毫米级动作执行的映射关系。在这种范式下,视觉模块提取的不再是抽象的物体标签,而是与后续动作执行密切相关的物理特征。

这种灵活性保证了端到端模型在训练时,每一个环节都能使用最前沿或最可靠(看开发者的具体需求)的算法组件,从而提升整体的「智能密度」。

框架原生:操作与导航的统一

在真实的物理任务中,机器人必须先走到目标前才能开始干活。这就要求框架必须同时具备「操作(Manipulation)」与「导航(Navigation)」的能力。

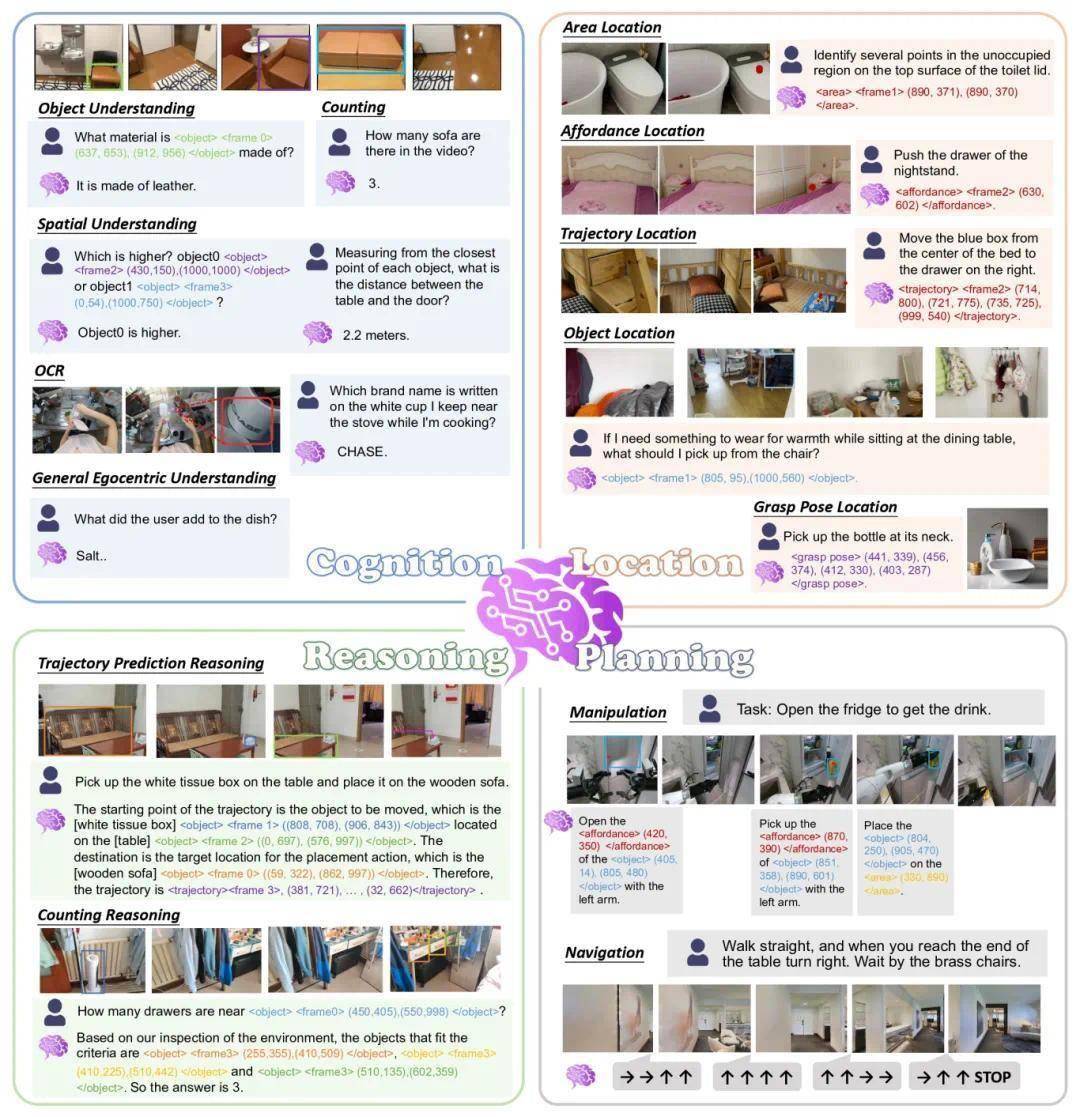

Dexbotic 2.0 在一个框架下实现了VLA(视觉-语言-动作)VLN(视觉-语言-导航)的统一。它集成了 Pi0.5、MemoryVLA、OpenVLA-OFT 以及原力灵机自研的 DM0 等多种 VLA 方案。同时,在导航层面支持 NAVILA,用于将语言目标与视觉观测对齐。这种融合是为了实现「能说清、能看准、能做对」的目标,并为 2026 年的「全身控制(Whole-body Control)」奠定技术基础。

汪天才对此评论说:「我们没有必要去区分到底是具身还是自动驾驶,又或是所谓的多模态大模型 —— 大家的目标应该是一致的:最终你要训出一个具身大模型。」

数据原生:多源数据混训

在具身原生的逻辑下,模型需要像人类一样同时学习理解世界与动手操作。Dexbotic 2.0 支持多模态数据与具身数据的 Co-training。这意味着系统使用同一套训练过程,让视觉语言模型在接收互联网图文与视频数据时,学习场景描述、任务拆解以及指令与画面中对象位置的精确对应。在此基础上接入动作专家,将这些语义理解结果转化为抓取、移动、放置等连续控制的动作序列。

这种混合训练模式让训练数据不仅包含互联网通用常识,也包含机器人实操的具身轨迹。两类数据共同优化,使模型既具备通用语义理解能力,又具备可落地的操作技能,真正做到「能说清、能看准、能做对」。下图展示了 Dexbotic 2.0 孵化的具身大模型 DM0 混训过程所使用的数据示例。

汪天才指出,这种多源混合训练甚至可以将自动驾驶数据与互联网智能体数据一并纳入,通过这种方式显著提升模型在各个领域的泛化性能与智能密度。「这也是我们具身原生框架的 feature 之一。」他举了个具体的例子,「就像训练一个人一样,我更期望这个人既能识别出这是一杯咖啡,也能输出对应的连续动作。我们要把比如说两张椅子之间的空间关系,以及生活中的很多常识,都包含到整个具身模型的训练中。」

训练原生:全流程标准化

目前,具身智能领域正面临着严重的研发碎片化挑战。由于不同仿真环境与硬件本体的接口各异,开发者往往需要耗费大量精力在数据格式适配、仿真器连接等底层工程上。这种高度零散的现状就像是早期数码产品混乱的充电接口,极大抬高了入行门槛。

为了终结这种「作坊式」的开发模式,Dexbotic 2.0 建立了从数据采集、训练管线到仿真评测的标准化全流程。在数据层面,框架推出了 Dexdata 数据格式,将庞杂的具身数据统一存储为标准化的 video 与 jsonl 标注文件。在仿真侧,系统深度适配了 SimplerEnv、ManiSkill2、RoboTwin 2.0 以及 Libero 等多种主流仿真器,确保算法能在统一环境下进行性能对比。此外,Dexbotic 2.0 还提供了将各类环境数据自动转换为 Dexdata 标准格式的工具链,确保了不同算法能在同一套环境下进行公平的性能对比。而在开源硬件方面,Dexbotic 2.0 更是直接支持了 SO-101 与 DOS-W1 等平台,从而实现了从标准数据到标准评测、再到真实机器人部署的一体化开发路径。

不仅如此,针对行业内真机评测「对比不公平」的痛点,原力灵机此前已经联合 Hugging Face 推出了被称为「具身智能 ImageNet」的真机评测基准 RoboChallenge。详情可参阅我们之前的报道《具身智能迎来 ImageNet 时刻:RoboChallenge 开放首个大规模真机基准测试集》。

汪天才指出,过去许多研究者通过针对单一任务进行「定向优化」(Hack)来刷高分数,这种「高分低能」的现象在具身领域尤为突出。RoboChallenge 的初衷便是通过统一的真机评价标准,排除变量干扰,真正检验基模的泛化能力。汪天才在采访中提到:「如果你的模型基模真的强,在榜单上一定会有所体现,它不存在那种被 Hack 出来的强大。」

通过将数据处理、训练管线与仿真评测标准化,并与 RoboChallenge 这一真机标准相结合,Dexbotic 2.0 可帮助开发者跳出底层工程的泥潭。当这些基础设施变得确定,开发者才能真正专注于提升模型对物理世界的理解深度。

训练原生:模仿学习与强化学习的统一

单纯依靠模仿学习(SFT)往往难以应对物理世界的高熵与极端场景。汪天才也在采访中特别强调了基础模型的重要性:「你的基模首先要够强,才能在一些更复杂的任务中有成功率。比如说,可能对于某个任务,我第一次去做强化学习,可能基模只有 30% 成功率。但它经过比如 3 ~ 4 轮的强化学习,可能就能升到 80%。但是如果基模不强,一开始的成功率是 0,也很难通过强化学习提升。」

Dexbotic 2.0 通过统一框架打通了从 VLA 策略初始化到强化学习(RL)后训练的闭环流程。系统首先通过 VLA 在海量多模态数据上学习通用语义、任务分解与动作先验,再借助强化学习在交互环境中进行持续试错与优化。这种演进路径旨在实现更高的任务成功率、更强的鲁棒性以及跨任务的泛化能力。

为了实现这一目标,Dexbotic 2.0 集成了SimpleVLA-RL工具,并与由清华大学、无问芯穹支持的强化学习框架 RLinf 达成深度战略合作。在这种分工中,Dexbotic 2.0 负责构建高质量的初始策略与数据体系,RLinf 则负责大规模 RL 后训练与工程化加速。

这种「预训练+强化学习」的组合模式,赋予了机器人应对动态环境的直觉反应。汪天才认为,这种全流程标准化的基础设施解决了以往真机强化学习效率极低的痛点,为未来实现几十台甚至上百台机器人的大规模自我演进奠定了基础。

从框架孵化到全链路落地

DM0 与 DFOL 的进阶路径

在原力灵机的技术版图中,Dexbotic 2.0 并非一个静态的工具箱,它在公司内部扮演着底层「母机」的角色。通过这一框架的滋养,原力灵机成功孵化出并开源了高性能的具身原生大模型 DM0,并以此为基础,进一步延伸出了面向实际作业场景的具身原生应用量产工作流 DFOL。这种「框架孵化模型、模型驱动应用」的递进逻辑,构成了公司完整的技术闭环。

DM0:追求「智能密度」的大脑

作为首个核心大模型成果,DM0 团队将研发重点放在了物理空间中的「智能密度」上 ——DM0 也是当今智能密度最高的具身大模型。值得一提的是,DM0 是原力灵机联合阶跃星辰共同训练的,除了深度融合多模态互联网信息外,还涵盖了驾驶行为、机器人操作等具身特有数据。

技术报告:DM0: An Embodied-Native Vision-Language-Action Model towards Physical AI报告地址:https://dexmal.com/DM0_Tech_Report.pdf

汪天才提到,我们往往低估了一个模型可以学习到的知识范围,成功率和步骤分两项指标大幅领先的 DM0 证明了小模型也能具备极强的泛化能力。

在 RoboChallenge 真机评测中,DM0 获得单任务与多任务双项第一,目前位居榜单全球第一。同时,凭借 2.4B 参数的体量和 62.0% 的单机成功率,DM0 也是当今智能密度最高的具身大模型。

DM0 采用 2.4B 参数的轻量化设计,支持三视角 728×728 高分辨率输入,能够实现跨 8 种机型的泛化,推理延迟仅为 60 ms 左右。

为了让模型学习操作的通用逻辑,DM0 引入了「空间推理思维链(Spatial CoT)」机制。在处理类似「对桌面商品扫码计价」的模糊指令时,模型会先进行子任务预测与规划,接着完成物体识别与精确定位,再生成 2D 轨迹,最终映射为可执行的 3D 动作。这种思维链将环境感知、任务理解、运动规划与精细执行串成了闭环。

DM0 模型架构示意图,其由一个 VLM 主干和一个基于流匹配(Flow Matching)的动作专家组成。VLM 处理多模态输入并生成具身推理表征,动作专家再利用这些表征生成连续的机器人动作。

DM0 操作原力灵机首款开源硬件产品 DOS-W1 执行扫码计价任务(使用了真机强化学习)

DFOL:解锁具身应用量产工作流

当 DM0 具备了强大的物理推理能力后,原力灵机又进一步推出了具身应用量产工作流 DFOL(Distributed Field Online Learning)。这一方案通过「硬件通用 + 模型智能」的模式,打破非标自动化与人工的边界。

DFOL 的关键创新在于构建了完整的数据回流机制。

在真实工作环境中,现场产生的训练片段(episode)与负样本块(negative chunk)会实时回传至云端,形成「云端训练 - 现场执行 - 数据回流 - 模型更新」的持续进化闭环。这使得机器人系统能够在实际作业中不断自我改进,实现从「展品」向「产品」的跨越,即以「一个标准化的、可预测的方式来完成具身智能的批量落地」。目前,利用该数据回流机制,DFOL 能让新任务在两天内达到量产标准。

经过 DFOL 方案之后的 DM0 操作 DOS-W1 分拣回收料,学习时长 48 小时,来自华勤技术

此外,为了验证商业价值,原力灵机还构建了评估落地的三大硬性指标:成功率、动作质量与节拍。这三者被总结为商业价值的「铁三角」,可作为行业内评估机器人真实场景应用的重要参考。

生态共建

开源协作下的加速进化

在原力灵机的逻辑里,真正的「PyTorch 时刻」不仅关乎技术底座的强大,更关乎开发者生态的繁荣。为了让 Dexbotic 2.0 能够真正触达每一位具身开发者,原力灵机宣布与由清华大学、无问芯穹支持的强化学习框架 RLinf 达成深度战略合作

关于为何坚定地选择开源路径,汪天才在采访中表达了极具开放性的心态。他认为具身智能仍处于非常早期的赛道,需要大家一起「添砖加瓦」。在他看来,具身智能领域很难由单一公司或团队颠覆,引入外部的贡献来增加赛道的势能和加速度是更有必要的做法。他指出:「我们更相信开源生态,开源生态的一个好处是大家都可以彼此分享经验,尤其是具身这样一个非常早期的赛道。」

在这次三方合作中,各方分工明确,像是一场精密配合的接力赛。Dexbotic 2.0 专注于 VLA 预训练与监督微调(SFT),负责构建高质量的初始策略与数据体系,为机器人提供具备常识的「大脑原型」。RLinf 则负责大规模 RL 后训练与工程化加速,通过在交互环境中进行海量的试错与对齐,提升策略在复杂、极端场景下的鲁棒性。

汪天才将这种合作评价为一种「握手」。他表示:「没有必要重复造轮子。我们两边其实可以做一个握手,然后就能把这件事情搞定 —— 各自关注更聚焦的那一部分。」这种分工可实现研发效率的最大化,让具身智能的 Infra 拼图变得更完整。

在 2 月 10 日的技术开发日上,原力灵机公布了与 RLinf 的「Dexbotic & RLinf 融合研发计划」,预计将在今年 5 月支持大规模真机强化学习,并在 6 月发布深度耦合的通用具身框架。

此外,正如前文所述,原力灵机选择开源 Dexbotic 2.0 及其标准化的 Dexdata 数据格式,还可以推动行业标准的统一。

目前,Dexbotic 已汇聚起横跨学术与产业的全球化社区,用户包括清华大学、北京大学、普林斯顿大学、帝国理工学院等顶尖学府,以及腾讯、通义千问、北京具身智能机器人创新中心等行业力量。这种广泛的信任投票证明了开源协作路径的价值。通过打造具身智能领域的 PyTorch,原力灵机正携手合作伙伴降低开发门槛,让开发者能专注于算法创新与场景突破,共同让具身智能从实验室走向生产线。

迈向物理 AGI 的进化之路

汪天才在采访最后分享了他对未来的洞察。在视觉、听觉之外,他特别强调了触觉与六维力的重要性,这些感官构成了具身原生的一部分,会直接影响对物理世界的建模能力。除此之外,他还透露了关于「听觉与语音交互」的规划,未来计划联合阶跃星辰等合作伙伴开发全模态模型,让机器人具备类似人类的听觉输入能力,进一步补全「具身原生」的形态。

汪天才对于具身智能的「进化」有着更深层的思考。他认为,未来的机器人不应当只是冷冰冰的执行机器,而应当具备感知疼痛、理解空间并能通过直觉做出反应的能力 —— 正如原力灵机的英文名Dexmal暗示的那样:成为像「灵巧的动物」(Dexterous Animal)一样的智能生命。这种进化不仅体现在算法架构上,更在于多模态传感信息的深度融合。作为这一进化逻辑的技术底座,Dexbotic 2.0 凭借其标准化的基础设施属性,成功衔接了模块化与端到端范式,致力于降低整个行业的研发门槛。

事实上,这种进化还在加速!从去年 10 月发布 Dexbotic 1.0 到如今 2.0 的推出,仅仅过去了三个多月。汪天才判断,具身智能的发展正在显著加速,这种高频迭代将成为常态。这种前文提到的「Dexbotic & RLinf 融合研发计划」也能看出。汪天才表示:「现在行业的迭代速度非常快,几乎每周都有新发布,就像大模型领域按天进化的节奏一样。」

具身智能的 PyTorch 时刻正在到来,那 ChatGPT 时刻还远吗?对此,汪天才有着更贴近现实的愿景:「首先一定要有个本体,并且本体的外形让人觉得没有威胁感,让人觉得安全。它在生活中能够帮我处理一些简单的事物,比如倒茶、擦擦桌子、跟我一块出去遛弯、聊聊天。就这样,像一个助手。我并不期望它能帮我换灯泡等高难度的事情,我没有那么高期待。」

对于从 CV 或 NLP 领域跨行进入具身领域的年轻研究者,汪天才建议要相信长期主义:「你要能够沉下心来去学习具身领域的各种知识,除了算法,还要有系统和硬件知识。你可能需要一到两年的时间先去做积累。」

随着开源生态的扩大,智能正在以前所未有的速度介入并改变真实的物理世界。原力灵机通过这一整套布局,已经为物理 AGI 勾勒出了一幅清晰的蓝图。

文中视频链接:https://mp.weixin.qq.com/s/8lCZm0X2pl-4BggzGovU2Q

京公网安备 11011402013531号

京公网安备 11011402013531号