衡宇 发自 凹非寺

量子位 | 公众号 QbitAI

忍不了了,这个槽我真的不吐不快!

比面对大模型黑盒更让人抓瞎的事情,就是要去选既靠谱、性价比又高的API服务。

这几乎是每一个涉足AI应用开发的团队都会经历的至暗时刻,抹泪.gif。

同一个模型架构在不同的供应商手里,不仅价格上有出入,延迟、稳定性、吞吐量等用户关心的指标,波动幅度简直堪比霸天虎过山车。

你说荒诞不,在API调用动辄几十万、上百万token的时代,API选型居然变成了一件靠经验反复试错的事儿。

这就导致想要接个API做开发,还得先被迫兼职下采购员。东市买骏马,西市买鞍鞯,必须把市面上的供应商挨个测一遍。

(写到这儿的时候,我的表情就是那个大家可以想象的痛苦面具闭眼表情包.jpg)

不er,就没有一个工具能把这些API的底裤扒得干净,让咱开发者省点心吗?

带着如此沉痛的心情跟周围人打听了一圈,你还真别说,有人告诉我有家清华系的AI Infra公司——清程极智,真就做了这个事儿。

产品叫AI Ping,之前没做过什么宣发,基本一直就靠口碑口口相传。

用一句话来概括功能,可以说它就像大模型API领域的大众点评。

用7×24小时持续运行的真实数据,替开发者把API各方面的底细都摸清楚,试图终结这个API选型的混沌时代。

这个大模型API的大众点评什么样?

咱们平时点个20块钱的外卖,下单前都要习惯性看看评分,避避雷。

动辄几十万、上百万Token调用的AI开发环节,却长期缺乏类似的公共参考体系,很多团队不得不尽己所能去比价比性能。但你懂的,个体能力有限,做不到那么全面。

这合理吗?显然不合理吧……TAT

清程极智家的AI Ping就把原本分散在各个团队内部,重复发生的API评测和对比过程,抽象成一项持续运行的基础能力,for everyone。

从使用角度看,AI Ping让开发者不用再面对几十个模型API,只需要在一个界面直接看清晰明白的对比结果就ok了。

不需要自己去写脚本测速,更不需要去跟销售扯皮,就能在海量的大模型服务中快速筛选出性能最优、性价比最高的API。

背后解决的是两个长期存在的问题。

一个是信息差。

厂商宣传的指标,和真实调用环境之间往往存在距离,而AI Ping跑出来的是实测数据。

另一个是重复劳动。

大量团队在做相似的评测工作,却很少形成可复用的公共结果。

所以咱们可以把AI Ping看作连接国产算力与应用端的第一道关口,相当于给开发者提供了一个开上帝视角的平台。

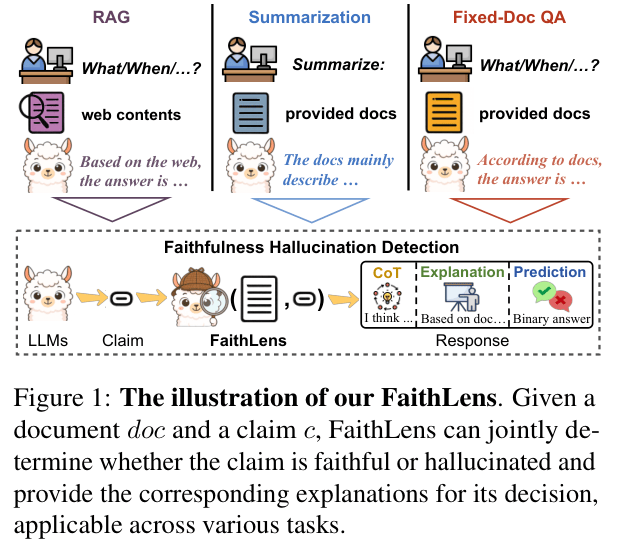

通过三大核心功能,AI Ping构建了这个大模型API大众点评的骨架。

具体来看——

第一大功能,7×24小时持续评测的客观性能和模型精度榜单。

这是AI Ping最基础的功能,旨在解决最根本的“盲选”和信息差问题(其实也最容易得罪人,哈哈哈)。

市面上的榜单很多,但大多数是静态的跑分。

AI Ping做的则是动态的监控。

实时的公开吞吐、P90首字延迟、稳定性等指标都会整理出来,图表化结果,一目了然。

在模型精度评测上,它更是下了狠功夫。

大家都知道,经过量化、剪枝或者不同推理框架加速后的模型,其输出精度往往会有细微的损失。对于严谨的业务场景,关注这种精度的波动还挺要紧的。

AI Ping引入了多维度的精度评估体系,持续监测同一个模型在不同时间段、及不同负载下的输出质量。

这就非常像中学期中考监考的教导主任,永远不知疲倦地在窗外盯着所有大模型,一旦有异动,榜单上立马就反馈出来。

第二大功能,也是最具技术含量的,是智能路由动态匹配。

为了方便大家理解,可以把AI Ping的智能路由理解成一套实时导航系统。

现实情况中,单一供应商的稳定性往往难以保证100%。还有很多意外,比如网络抖动、机房故障、算力拥塞啥的,都可能导致服务中断。

AI Ping的智能路由功能可以根据实时的评测数据,帮助接入侧动态选择最合适的执行路径。

举个例子~

比如你发起了一个请求,AI Ping会瞬间分析当前各家供应商的状态。如果它发现A供应商现在的延迟很高,或者B供应商的错误率正在攀升,它会自动将你的请求路由到表现最好的C供应商那里。

这种动态匹配能保证系统运行的持续可用性,毫秒级延迟差异直接决定了代码生成的流畅度,提升了整体的执行效率。

第三大功能正是AI Ping更偏基础设施属性的一部分,我们下面单独开一part来说——

统一了大模型API的度量衡

我们把AI Ping称作大模型API的“大众点评”,不只是因为两者提供的功能相似,更主要的是,AI Ping背后同样拥有硬核的评测体系。

这就要好好说道说道AI Ping的第三大功能,也是最考验Infra功力的功能:它在多个维度上统一了大模型API的度量衡。

首先,AI Ping提供了多平台统一API接口。

市面上不同厂商的API每家都有自己的SDK,每家都有自己的参数定义。

想要接入,真的是一场旷日持久令人头痛的恶战……别问我怎么知道的。

这时候,AI Ping就挺身而出,充当了一个万能转接头的角色。

它提供了一套标准化的API接口,开发侧只需要面对这一种调用方式。

无论后端对接的是文心、Qwen、GLM还是Kimi,对于开发者来说代码都是一样的。压根儿不需要费心修改业务代码,几秒钟内就轻轻松松完成不同模型、不同平台之间的接入与切换。

对开发团队来说,这种统一接口也意味着更低的维护成本和更快的迭代节奏。

其次,它还针对行业里API性能“各说各话”的混乱状态提供了一套规范。

此前,行业里关于API性能的描述是混乱的,有的平台强调单次延迟,有的平台强调峰值吞吐,有的只给理想条件下的数据。

不同统计口径叠加在一起,几乎无法横向比较。

针对这个市场缺口,AI Ping一是确立了一套硬核指标,把指标定义、采集方式与统计口径彻底固定了下来。

比如,它严格区分了TTFT(首字生成时间)和E2E Latency(端到端延迟),明确了不同Prompt长度下的性能基准。

这种标准化的做法让结果具备可比较性和可复现性。

二来,它拒绝注水,坚持数据说话。

和让人摸不着头脑的营销词汇说bye bye,和可信赖的数字说hi hi~

一般来说,厂商通常关注的是能力展示,而AI Ping这样持续大规模的真实调用数据,更容易暴露细节差异。

这种颗粒度的洞察带来了一个神奇的结果:在某些维度上,AI Ping对模型API的理解,甚至会超过厂商自身公开的信息。

由于具备上述专业性,这套评测标准已经开始成为行业的共识。

去年,AI Ping就已经支撑清华大学与中国软件评测中心联合发布了2025大模型服务性能榜单。

这里不得不提一个开发侧非常有吸引力的价值点,那就是AI Ping上的API多数情况下可能比你自己直接去厂商那儿调用更有性价比。

为啥?因为清程极智作为资源聚合者,有海量的调用需求,形成了巨大的买方市场,于是带来了集采效应。

团购总比单点划算嘛,你懂得的~

为什么是清程极智来做?

看到这里,我们回到一个关键问题:

市面上那么多大厂,那么多评测机构,为什么是清程极智来做这件事,还把AI Ping做得挺好?

这就得好好聊聊清程极智是谁了。

成立于2023年12月的清程极智一直深耕算力调度、系统优化和基础设施层。

几天前,这家公司举行了一次线下产品发布会,会上明确表明把AI Ping视为其“双重桥梁”定位的落地载体。

所谓“双重桥梁”,第一重是指“算力与应用之间的桥梁”,让上层开发不必被底层资源差异反复干扰;第二重则是指“国产硬件与大模型之间的桥梁”,降低不同硬件环境下模型调用的不确定性。

这就很好理解为什么清程极智适合做AI Ping这样一个产品了。

首先,它是一个中立的基础设施角色。

清程极智自己不开发大模型,不自持算力提供MaaS服务,就不会出现自己既当裁判又当运动员的尴尬情况。第三方检测的身份更能保证评测结果的客观性和公正性。

其次,它拥有独特的行业理解视角。

清程极智长期处在算力部署与模型服务的一线,既懂底层的芯片和硬件,也懂上层的模型和应用。

这样的角色对算力侧的调度难点、平台侧的优化瓶颈、调用侧的真实痛点有深度的协同理解。

团队能透过API看到背后的算力调度逻辑——这就是内行看门道。

最后,清程极智还拥有能做好这件事的深厚技术底座。

要实现7×24小时的高并发评测和毫秒级的智能路由,没有硬核的技术实力是玩不转的。

AI Ping并不是孤立存在的工具。在AI Ping发布之前,清程极智就已经围绕国产GPU,在算力调度、异构芯片适配、以及大规模集群系统优化等底层领域积累了大量的战绩。

仅2025年,清程极智就陆续完成了赤兔(Chitu)推理引擎发布并开源、八卦炉(Bagualu)智能计算软件栈适配验证等产品的亮相。

在AI Infra领域的长期积累,为其构建这套复杂的监测与路由系统提供了坚实的底座。

也正因为底层足够硬,AI Ping才能把复杂评测结果“翻译”成人人看得懂的榜单,方便更多的模型调用者。

AI Ping填补了国内大模型服务实时性能监测的空白。

它用榜单、评分这种一目了然又通俗易懂的方式,让大家明白每一家模型具体怎么样,就像当年大众点评让大家知道“哪家馆子好吃”一样。

如果从更长远的生态意义来看,AI Ping的价值是超越一个产品本身的——对行业来说,它正在扮演一个“先锋者”的角色。

它身先士卒,呼吁大模型API选型的透明化。

随着越来越多生态企业围绕AI Ping发布联合成果与调研结论,大模型API的选型逻辑开始发生质的转变,从经验驱动走向数据驱动。

这种转变将产生巨大的倒逼效应。

就像餐厅为了好评必须提升菜品质量一样,供应商为了在AI Ping上获得更好的排名和更多的流量,必须不断优化自己的服务质量,提升稳定性,降低延迟。

这将促进整个供应侧的良性竞争,从而降低全行业的开发与选型成本,最终推动AI生态向着更规范、更高效的方向发展。

京公网安备 11011402013531号

京公网安备 11011402013531号