机器之心报道

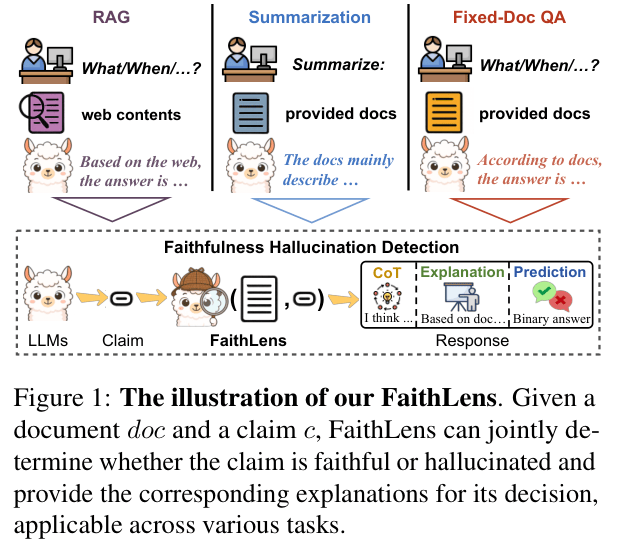

编辑:+0

近期各大 AI 公司大动作频出,Meta FAIR 部门遭裁员、OpenAI 资本重组、AWS 大裁员……这一系列动荡表明 AI 行业正从「无限淘金热」转向残酷的「阵地战」。资本开始重新评估价值,巨头们在激烈的军备竞赛中也不得不审视成本与效率。

那么,这场「阵地战」是怎么打起来的?巨头们手里的牌、背上的包袱,又是怎么来的?

知名科技播客《Acquired》最近的一期节目,以谷歌(Google)的 AI 发展史与战略为主线,巧妙地穿插了其他 AI 巨头的崛起历程,节目几乎涵盖了当今 AI 领域大部分的关键人物,为听众系统地梳理出一部简明的 AI 发展史。

播客地址:https://www.acquired.fm/episodes/google-the-ai-company

本文将循着《Acquired》这期节目的讨论脉络,同时深入挖掘并征引节目中提及的两本关键著作《In the Plex》与《Genius Makers》(中文版:深度学习革命)中的相关细节,结合当下 AI 圈现状,对 AI 的发展历史与大公司战略博弈进行一次深度的复盘。

刻在谷歌基因里的 AI 目标

不同于许多后来者,人工智能并非谷歌在某个阶段才「转向」的风口,而是从诞生之初就是其核心理念。

1998 年,Google 成立。创始人之一 Larry Page 将谷歌视为一家人工智能公司,这很大程度上源于他父亲——一位早期就专注于机器学习和人工智能领域的计算机科学教授的影响。

让我们先把时间拨回 42 年前:1956 年。在美国的达特茅斯学院,一群充满激情的科学家们正式提出了「人工智能(Artificial Intelligence)」这个名字。他们乐观地相信,用不了多久,具有人类智慧的机器就将出现。

然而,现实很快给过于乐观的预言泼了冷水。由于计算能力的限制、数据的匮乏以及理论的瓶颈,许多承诺无法兑现,AI 研究的资金和热情随之骤减,进入了长达数十年的两次「AI 寒冬」。

在那个 AI 被普遍视为「浪费时间」的年代,Larry Page 父亲的坚持就颇具反叛色彩。

Larry Page 在 2000 年就断言:「人工智能将是谷歌的终极版本……如果我们拥有终极搜索引擎,它将理解网络上的一切……这显然就是人工智能……我们正朝着这个方向努力」。

甚至可以说,谷歌赖以起家的 PageRank 算法,其本身运用统计方法排序网页,就已带有早期 AI 思想的印记。

「压缩即理解」

谷歌 AI 故事的一个关键源头,始于 2000 年末或 2001 年初的一次午餐闲谈。早期工程师 George Herrick 向同事 Ben Gomes 及 Noam Shazeer 提出了一个理论:压缩数据在技术上等同于理解数据。核心在于,高效压缩并能无损恢复信息的过程,本身就蕴含了对信息的深层理解。

这个想法吸引了天才工程师 Noam Shazeer。在当时谷歌自由的工程师文化下,Herrick 和 Shazeer 决定全力探索语言模型和机器理解。尽管并非所有人都看好,但 Jeff Dean 等人的支持给了他们信心。

他们的研究深入到自然语言的概率模型领域,即预测给定词语序列后,下一个最可能出现的词语序列是什么。这正是现代 LLM 「Next Token Prediction」思想的早期体现。

这项研究的首个直接成果,就是谷歌搜索中极为实用的「您是不是要找」(Did you mean)拼写纠错功能,由 Shazeer 主导开发。它不仅改善了用户体验,还通过减少错误查询,为谷歌节省了大量无效计算资源。

随后,他们构建了一个在当时看来相当「大」的语言模型,并将其命名为PHIL(Probabilistic Hierarchical Inferential Learner,概率分层推理学习器)。这个模型很快在谷歌的核心业务中扮演了关键角色。

2003 年,PHIL 被 Jeff Dean 用于快速实现 AdSense 系统,理解网页内容以匹配广告。AdSense 一夜之间为谷歌带来了数十亿美元的新收入。

到了 2000 年代中期,据估计 PHIL 消耗了谷歌数据中心整体资源的 15%,足见其重要性与计算强度。

机器翻译与神经网络

谷歌对语言理解能力的追求,自然延伸到了机器翻译领域。

2007 年前后,由 Franz Och 领导的 Google Translate 团队,Och 团队构建了一个基于海量 N-gram(词语组合)的语言模型,该模型在一个包含两万亿单词的谷歌搜索索引子集上进行了训练。团队凭借巨大的 N-gram 模型赢得 DARPA 竞赛,但模型效率极低,翻译一句话需 12 小时。

Jeff Dean 再次介入,他意识到翻译过程可并行化,利用 Google 强大的分布式计算平台,与团队合作在数月内将翻译时间缩短至 100 毫秒,成功将其投入生产。这成为谷歌第一个生产环境的「大型」语言模型,进一步激发了将此类技术用于更多场景的想象。

与此同时,另一股更具革命性的思潮也开始悄然叩响谷歌的大门:神经网络与深度学习。这,得益于 Sebastian Thrun 的引荐。

这位前斯坦福 AI 实验室(SAIL)主任于 2007 年加入 Google,在成功主导「Ground Truth」地图项目后,他说服 Larry Page 和 Sergey Brin 邀请顶尖学者兼职参与 Google 研究。

2007 年 12 月,Sebastian Thrun 邀请了当时在多伦多大学、相对不为人所知的机器学习教授 Geoff Hinton 来到谷歌进行技术讲座。

Hinton 是神经网络研究的长期倡导者,他和他的学生(包括 Yann LeCun)坚信,随着计算能力的提升,构建更深层次的神经网络(即「深度学习」)将能释放其巨大潜力。

Hinton 的讲座在谷歌内部引发了强烈反响,特别是让 Jeff Dean 等人看到了现有语言模型工作的全新可能性。随后,辛顿以顾问乃至「实习生」的身份开始与谷歌合作,将深度学习的火种正式带入了这家未来的 AI 巨头。

值得一提的是,Hinton 等人所倡导的神经网络,在当时正处于被学术界边缘化的最低谷。如《Genius Makers》所述,自 70 年代 Marvin Minsky 对「感知机」的著名批判以来,AI 领域的主流已转向「专家系统」。然而专家系统在现实世界的复杂性面前屡屡碰壁,导致了 AI 的第二次寒冬。

而 Google 的 PageRank 和机器翻译所依赖的统计方法,本身就是对僵化专家系统的一种反叛。Hinton 的到来,预示着一种基于数据、统计和仿生计算的更深刻范式,即将与 Google 的工程能力相结合。

到 2011 年,谷歌不仅在传统机器学习和大规模系统工程方面积累了深厚实力,也开始接触并拥抱深度学习这一即将掀起滔天巨浪的新思潮。人才的引进、内部项目的成功以及对前沿理论的开放态度,共同为谷歌下一阶段的 AI 爆发奠定了坚实的基础。

从「大脑」到「猫」

Hinton 带来的深度学习火种,很快在 Google 内部找到了适宜生长的土壤。大规模数据和强大的计算基础设施,恰是神经网络研究所需的关键要素。

正是在这一背景下,Google 内部一个专注于将深度学习推向新高度的核心团队应运而生,并迅速取得了令世界瞩目的突破。

Google Brain 诞生

随着 Sebastian Thrun 全职加入 Google 并创建 Google X 部门,他将在斯坦福 AI 实验室(SAIL)的继任者、另一位杰出学者吴恩达(Andrew Ng)也引入 Google 兼职。

值得一提的是,近日,英伟达市值突破5万亿美元,而吴恩达及其团队早在 2009 年的一篇论文中就指出了 GPU 对 AI 重要性。

论文标题:Large-scale Deep Unsupervised Learning using Graphics Processors论文地址:https://dl.acm.org/doi/10.1145/1553374.1553486

回到正题。2010 至 2011 年间的一天,吴恩达在 Google 园区偶遇 Jeff Dean,两人交流起各自在语言模型和深度学习方面的想法。他们很快意识到,结合 Hinton 的理论与 Google 无与伦比的并行计算能力,或许可以真正构建一个前所未有的大规模深度学习模型。

这个想法很快得到了推动。2011 年,吴恩达、Jeff Dean 以及神经科学博士 Greg Corrado 共同发起了 Google X 内部的第二个官方项目:Google Brain。他们的目标明确:在 Google 的基础设施上,构建一个真正「深」且「大」的神经网络。

为了支撑这个庞大的计算任务,Jeff Dean 主导开发了一个名为 DistBelief 的新分布式计算系统。

DistBelief 的设计颇具争议,它允许不同计算节点异步更新模型参数,这意味着更新可能基于「过时」的信息。这与当时主流研究认为同步更新对保证模型收敛至关重要的观点相悖。

许多人,包括 Google 内外的专家,都对此表示怀疑(Disbelief),这也是系统名称的双关含义。然而,Jeff Dean 的工程直觉再次被证明是正确的,DistBelief 不仅可行,而且效率很高。

石破天惊的「猫论文」

有了强大的计算平台,Google Brain 团队迅速展开了一项里程碑式的实验。他们构建了一个包含九个层级的深度神经网络,并利用 DistBelief 系统,在 1000 台机器上的 16000 个 CPU 核心进行训练。训练数据是 1000 万帧从未经人工标注的 YouTube 视频中随机抽取的。

实验结果震惊了世界。这个神经网络在没有被告知什么是「猫」的情况下,通过无监督学习,自主地在最高层网络中形成了一个「猫神经元」:这个神经元会对包含猫脸(特别是正面视角)的图像产生强烈兴奋,而对其他图像则反应平淡。

这项成果,后来以论文形式发表,但更广为人知的名字是「猫论文」(Cat Paper)。

论文标题:Building High-Level Features Using Large-Scale Unsupervised Learning论文地址:https://arxiv.org/abs/1112.6209

「猫论文」的意义极其深远。首先,它证明了大规模深度神经网络具备在没有人类监督的情况下,从海量原始数据中学习有意义的高级特征的能力。其次,它验证了 Google 自研的分布式系统能够有效支撑这种规模的训练。

对于 Google 内部而言,这次成功极具说服力。据时任高管的 Sundar Pichai 回忆,看到「猫论文」是他记忆中 Google AI 故事的关键时刻之一。在一次 TGIF(Thank God It's Friday,谷歌内部周五例会)上展示该成果后,许多员工表示「一切都改变了」。

更重要的是,「猫论文」直接催生了巨大的商业价值。当时 YouTube 面临着视频内容理解不足的难题,用户上传的标题和描述往往不足以支撑有效的搜索和推荐。Google Brain 的技术使得机器能够「看懂」视频内容,极大地提升了 YouTube 的推荐精度和用户粘性,也为后续的内容审核、版权识别等关键功能奠定了基础。

可以说,「猫论文」开启了 YouTube 乃至整个社交媒体和内容平台的「算法推荐时代」,间接驱动了此后十年数百亿乃至数千亿美元的产业价值。

AlexNet

几乎与「猫论文」同时期,另一项来自学术界的突破则彻底改变了深度学习的硬件基础。

2012 年,在多伦多大学,Geoff Hinton 指导的两名学生 Alex Krizhevsky 和 Ilya Sutskever,凭借他们设计的深度卷积神经网络 AlexNet,在著名的 ImageNet 图像识别竞赛中取得了「大爆炸」式的成功。

ImageNet 竞赛要求算法识别数百万张已标注图片中的物体。此前数年,最优算法的错误率仍在 25% 以上。而 AlexNet 横空出世,将错误率一举降至 15.3%,比前一年最好的结果提升了超过 40%。

这一飞跃的关键,在于 Krizhevsky 和 Sutskever 创造性地使用了两块当时主要用于游戏图形处理的 NVIDIA GeForce GTX 580 GPU 进行并行计算训练。他们意识到 GPU 的大规模并行计算架构天然适合神经网络运算,并通过 NVIDIA 的 CUDA 编程语言重写了算法。

AlexNet 的胜利不仅宣告了深度学习时代的全面到来,更确立了 GPU 作为 AI 计算核心硬件的地位。正如 NVIDIA CEO 黄仁勋所言,这是 AI 的「大爆炸时刻」。这一事件也直接将 NVIDIA 从一家 PC 游戏配件制造商,推上了日后 AI 浪潮之巅,成为全球市值最高的公司之一。

DNN Research 收购大战

AlexNet 的巨大成功让其背后的三人团队身价倍增,他们迅速成立了一家名为 DNN Research 的公司,这家公司没有产品,唯一的资产就是这三位顶尖的 AI 研究大脑。

一场围绕这家初创公司的激烈竞购战随之展开。Hinton 决定采用一种类似拍卖的方式来决定公司的归属,以期获得公平的市场价值。

最初百度出价 1200 万美元,随后,谷歌、微软以及当时还名不见经传的初创公司 DeepMind 都加入了竞标。竞价在内华达州太浩湖哈里斯赌场酒店(NIPS/NeurIPS 会议期间)Hinton 的房间里激烈进行。

DeepMind 因资金不足早早退出,最终,竞价在谷歌和百度之间进行,一路飙升。当价格达到 4400 万美元时,考虑到谷歌的研究环境、资源以及已有的人脉关系,Hinton 团队决定停止竞价,接受了谷歌的收购要约。

据说,他们三人最初计划平分股权,但 Krizhevsky 和 Sutskever 主动提出让导师 Hinton 占 40%,他们各占 30%。

这次收购被认为是谷歌 AI 历史上最划算的交易之一。它不仅将 AlexNet 的核心团队整体并入 Google Brain,进一步巩固了谷歌在深度学习领域的领导地位,而且这支团队后续为谷歌创造的价值被认为远超收购价格,甚至足以覆盖 Google X 部门的所有其他「登月项目」的投入。

Facebook 与 FAIR

AlexNet 的惊人表现和 Google 对 DNN Research 的迅速收购,点燃了科技巨头对深度学习人才的渴望。Google 并非唯一的买家,扎克伯格也敏锐地意识到了这场风暴。

正如《深度学习革命》中所述,扎克伯格意识到,Google 用来优化 YouTube 推荐和广告的技术,同样可以用来改造 Facebook 的核心产品:动态消息(News Feed)。他将 AI 视为「下一个大事件」,并决心迅速建立 Facebook 自己的顶尖 AI 实验室。

扎克伯格的目标非常明确:他需要一位像 Geoff Hinton 一样的领军人物。这个人选就是 Hinton 的前博士后、当时在纽约大学任教的Yann LeCun。LeCun 是深度学习领域的另一位「教父」,尤其以其在卷积神经网络(CNNs)上的开创性工作而闻名。

2013 年,扎克伯格亲自致电 LeCun,力邀其加盟,并给出了非常有诚意的让步:FAIR(Facebook AI Research) 实验室可以设在纽约,LeCun 本人也可以保留在纽约大学的教职。

更重要的是,LeCun 坚持 FAIR 必须采用开放的研究模式,即像学术界一样公开发表论文。他认为这是吸引和留住顶尖人才的唯一途径,因为顶尖学者渴望的是同行认可和推动科学进步,而非仅仅是高薪。扎克伯格同意了这一点,这与 Google Brain 当时逐渐形成的开放研究文化不谋而合。

如我们所见,FAIR 为 Meta(原 Facebook)提供了源源不断的核心技术、开源工具(PyTorch)和前沿探索。

FAIR 通过其Llama系列模型为 Meta 确立了独特的战略地位。从 Llama 1 到 Llama 3,FAIR 开发了行业领先的开源大语言模型。 坚持开源策略,使 Meta 成为开放 AI 生态的领导者,对抗了 OpenAI 和 Google 的闭源模型。

但在 AI 竞争日益残酷的今天,从限制论文发表到裁员,FAIR 也不可避免地迎来了「理想主义」的退潮,开始直面成本与效率的残酷考验。

DeepMind、TPU 以及 OpenAI 的崛起

在收购了 DNN Research 的核心团队后,Google 在深度学习领域的领先地位似乎更加稳固。然而,AI 的版图远未定型。接下来的几年,Google 通过一次世纪收购进一步扩张了其 AI 帝国,但也同时在内部启动了一场深刻的硬件革命以应对算力挑战。

与此同时,其强大的「人才引力场」也开始显现离心力,催生了日后最强劲的竞争对手。

DeepMind 与 Google

就在 Google Brain 高歌猛进之时,大西洋彼岸的伦敦,一家名为DeepMind的初创公司正以其「解决智能,再用智能解决一切」的宏大愿景吸引着特定圈层的注意。

由神经科学博士、前游戏开发者 Demis Hassabis、Shane Legg 以及 Mustafa Suleyman 共同创立的 DeepMind,目标直指通用人工智能(AGI),这在当时被许多人视为「疯子般的边缘想法」。

DeepMind 早期获得了 Peter Thiel(PayPal 联合创始人、Facebook 首位外部投资人)和马斯克的投资。随着 DeepMind 在强化学习(尤其是在玩 Atari 游戏上取得突破)等领域展现出惊人潜力,它很快吸引了科技巨头的目光。

2013 年末,扎克伯格率先提出收购,据传报价高达 8 亿美元,但因无法满足 DeepMind 保持独立研究和设立外部监督委员会的要求而未能成功。Elon Musk 也提出用 Tesla 股票收购,意图将其技术用于自动驾驶,同样与 DeepMind 的核心目标不符。

关键的转折点来自 Larry Page。他对 AI 的长期愿景与 Hassabis 一拍即合,相比扎克伯格和马斯克,Page 更能理解并愿意支持 DeepMind 保持相对独立,专注于 AGI 研究。Google 内部已有 Google Brain 负责产品应用,DeepMind 可与之互补。此外,Google 拥有的庞大计算资源对 DeepMind 也是巨大的吸引力。

最终,Google 在 2014 年初以约 5.5 亿至 6.5 亿美元的价格成功收购 DeepMind。这笔收购在当时被视为谷歌的巨大胜利,但也埋下了日后内部文化冲突的种子。

DeepMind 长期与 Google Brain 在公司内部争夺资源和主导权,这种内耗在一定程度上拖慢了谷歌的脚步。而当年被谷歌重金「买下」的联合创始人 Mustafa Suleyman,在经历了内部的边缘化后最终离开,并极具戏剧性地在 2024 年加入了谷歌的死敌微软,成为了其消费者 AI 业务的负责人,调转枪口与老东家正面对垒。

收购后,DeepMind 迅速展现价值,不仅在AlphaGo项目中击败世界围棋冠军李世石,震惊世界,还通过优化算法将 Google 数据中心的冷却能耗降低了 40%。

然而,这次收购也彻底激怒了马斯克,为日后 OpenAI 的诞生埋下了最重要的伏笔。

从 GPU 依赖到自研 TPU

就在 Google 将 DeepMind 收入囊中,进一步巩固其在 AI 研究领域地位的同时,其内部也正悄然进行一场硬件革命。

AlexNet 的成功已经证明了 GPU 在深度学习训练中的巨大优势。Alex Krizhevsky 加入 Google 后,惊讶地发现公司内部仍主要依赖 CPU 进行模型训练,甚至自己买了 GPU 偷偷使用。

虽然 Google 内部早有人提出使用 GPU,但基础设施团队出于维护同构集群简单性的考虑一直有所抵触。然而,随着深度学习应用(如语音识别)的需求爆炸性增长,仅仅依赖 CPU 已难以为继。

Jeff Dean 甚至估算,如果所有 Android 用户每天使用几分钟语音识别,Google 就需要将现有数据中心规模翻倍才能支撑。他向负责基础设施的 Urs Hölzle 直言:「我们需要再造一个 Google。」

面对如此严峻的算力瓶颈和对外部供应商(主要是 NVIDIA)日益增长的依赖,Google 决定另辟蹊径:自研专门用于神经网络计算的芯片。

基于 Jonathan Ross 等工程师在 20% 时间项目中使用 FPGA(现场可编程门阵列)的探索,Google 正式立项开发 ASIC(专用集成电路),即 TPU(Tensor Processing Unit)。

TPU 的核心设计理念是针对神经网络中大量的矩阵(张量)运算进行优化,并大胆采用了低精度计算。通过牺牲一定的计算精度(例如,只保留较少的小数位数),可以在同样的功耗和芯片面积下,大幅提升计算吞吐量。这对于容错性相对较强的神经网络模型来说是完全可行的。

TPU 项目推进神速,15 个月内完成设计到部署,并巧妙设计成可替换服务器硬盘的形态。TPU 在 AlphaGo 对决中首次亮相并取得成功,此后成为 Google AI 基础设施的核心竞争力,为其提供了显著的成本优势和战略自主权。

OpenAI 的诞生

Google 对 DeepMind 的收购,以及其在 AI 人才和算力上的绝对优势,让马斯克越发警惕。他担心 Google 会在 AGI 研发上形成垄断,并可能带来不可控的风险。

这种担忧促使他在 2015 年夏天,联合时任 Y Combinator 总裁的 Sam Altman,在硅谷心脏地带的 Rosewood 酒店组织了一场旨在「策反」顶尖 AI 研究员的晚宴。

他们的目标是说服在 Google 和 Facebook 等巨头工作的研究人员,加入一个全新的、非盈利的、旨在为全人类福祉而开放研究 AGI 的实验室。

然而,面对 Google 提供的优厚待遇、顶级同事和无限资源,绝大多数受邀者都表示无法被撼动。唯一的例外是 Ilya Sutskever,这位 AlexNet 的共同作者、已在 Google Brain 做出杰出贡献的研究员,被 OpenAI 的开放、非盈利和「造福人类」的使命深深吸引。尽管 Jeff Dean 亲自出面提供了极具竞争力的反聘方案(据传是双倍薪酬),Sutskever 还是毅然决定加入这个前途未卜的新生组织。

他的加入起到了关键的示范效应,吸引了包括 Dario Amodei 在内的一小批顶尖人才离开 Google,构成了 OpenAI 最初的核心技术力量。

从事后看,这段「出走」充满了历史的回旋镖。Ilya Sutskever,这位被「造福人类」使命感召的联合创始人,在多年后成为了那场罢免 Sam Altman 董事会政变的关键人物,最终在内斗后黯然离开了公司。而与他一同离开 Google 的 Dario Amodei,后来也因对公司安全和商业化路径的根本分歧,带领一批核心成员出走,创办了 OpenAI 的直接竞争对手 Anthropic。

OpenAI 于 2015 年底正式宣告成立,获得了来自马斯克、Sam Altman 等人的 10 亿美元初始承诺捐款(尽管实际到位的远少于此)。

在最初几年,OpenAI 的研究路径很大程度上追随 DeepMind,专注于在复杂的游戏环境(如 Dota 2、Atari 游戏)中训练 AI 智能体,以此展示其实力并推动 AGI 研究。

谷歌的「馈赠」与 AI 新纪元

当 Google 同时拥有 Google Brain 和 DeepMind 两大顶尖 AI 实验室,并掌握了自研芯片 TPU 这一算力利器时,它在全球 AI 领域的领导地位似乎已无可撼动。

然而,历史的吊诡之处在于,一项源自 Google 内部、本意是为了改进机器翻译的研究成果,最终却成为了「潘多拉魔盒」,不仅为竞争对手提供了赶超的「奇点」,也迫使 Google 自身陷入了一场前所未有的「创新者窘境」保卫战。

这便是 Transformer 的故事,它开启了 AI 的新纪元。

Attention Is All You Need

2017 年,那篇堪称伟大的论文出现在 arXiv 上:Attention Is All You Need,署名是来自 Google Brain 的八位研究员。

论文标题:Attention Is All You Need论文地址:https://arxiv.org/abs/1706.03762

这篇论文旨在解决当时主流用于处理序列数据(如语言)的循环神经网络(RNN)及其变种长短期记忆网络(LSTM)所面临的两个核心难题:难以捕捉长距离依赖关系,以及计算过程难以并行化。RNN/LSTM 在处理句子时需要按顺序逐词进行,这限制了利用现代硬件进行大规模并行训练的效率。

论文提出了一种全新的神经网络架构:Transformer,其核心是一种被称为「自注意力」的机制。自注意力机制允许模型在处理序列中的某个词时,同时「关注」到序列中所有其他词与该词的关系及其重要性,而不受距离远近的限制。这种基于注意力的计算过程可以高度并行化,完美契合了 GPU 和 TPU 等并行计算硬件的优势。

Transformer 架构极其简洁、优雅,甚至让一些研究者最初怀疑「这不可能有效,太简单了」。但在 Google 内部,由 Noam Shazeer 等核心人物的深度参与和优化下,基于 Transformer 的模型在机器翻译任务上很快就超越了当时最先进的基于 LSTM 的系统。

更令人兴奋的是,研究人员发现 Transformer 模型展现出惊人的「可扩展性」:随着模型规模增大、训练数据增多,其性能似乎可以持续、可预测地提升。

这预示着一种全新的 AI 范式:「更多数据 + 更大模型 + 更多算力 ≈ 更好的智能」,正如后来 Rich Sutton 在其著名文章《苦涩的教训》中所总结的那样。

论文的作者们在末尾也富有远见地指出,计划将 Transformer 应用于文本之外的图像、音频和视频等模态。

Google 内部迅速认识到了 Transformer 的重要性,并基于它开发了 BERT 等模型,显著提升了 Google 搜索理解用户查询意图的能力,进一步巩固了其核心业务。

然而,遵循其一直以来的开放研究传统,Google 允许这篇论文公开发表。这一决定,虽然促进了整个 AI 领域的进步,但也无异于将开启下一个时代的「钥匙」交给了全世界——包括其潜在的竞争对手。

更具讽刺意味的是,在接下来的几年里,这篇论文的全部八位作者因各种原因相继离开了 Google,其中就包括后来回归并成为 Gemini 技术负责人的 Noam Shazeer。

OpenAI 转型

当 Transformer 论文发表时,OpenAI 正处于关键的十字路口。

Elon Musk 由于在公司发展方向(特别是与 Tesla 自动驾驶的结合)、控制权以及对进展速度的不满,于 2018 年初与 OpenAI 分道扬镳,并撤回了后续的资金支持。这使得原本就资金不算充裕的 OpenAI(10 亿美元承诺仅到位约 1.3 亿)陷入了生存危机。

与此同时,OpenAI 的研究团队敏锐地捕捉到了 Transformer 架构的巨大潜力。他们意识到,基于 Transformer 构建大规模预训练语言模型(即 GPT 系列)是一条充满希望的技术路径。然而,训练这些巨型模型需要天文数字般的计算资源,这远非一个非盈利组织所能负担。

在资金和算力的双重压力下,Sam Altman 做出了一个改变 OpenAI 命运的决定:

2018 年,微软同意向 OpenAI 投资 10 亿美元(部分为 Azure 云信用额度),以换取其技术的优先使用权和一定的商业化独占权。为了促成这笔交易,OpenAI 进行了一次颇具争议的重组,设立了一个「利润上限」的营利性子公司 OpenAI LP,由非盈利的母公司 OpenAI Inc. 控制。

最近,OpenAI 宣布的重大资本重组,当年那个为生存而设立的「利润上限」子公司,如今已演变为估值超 1300 亿美元的「公开利益公司」(OpenAI Group PBC)。而最初的非盈利母公司,现在成为了「OpenAI 基金会」,仅凭其持有的 26% 股权,就有望成为「历史上资源最充足的慈善组织之一」。

说回 OpenAI 和微软的合作,这次「联姻」对双方都意义重大。OpenAI 获得了续命的资金和进行大规模模型训练所必需的 Azure 云计算资源;而微软则通过这笔在当时看来颇具风险的投资,在 AI 竞赛的关键时刻绑定了一个潜力无限的技术伙伴,为其后续在 AI 应用层(如 Bing 搜索、Office Copilot)的快速布局奠定了基础。

与此形成对比的是,Google 拥有自己的云平台 Google Cloud 和自研芯片 TPU,在基础设施上完全自给自足。

获得了微软支持后,OpenAI 开始全力投入 GPT 模型的研发。GPT-2(2019 年)和 GPT-3(2020 年)相继发布,模型能力不断提升,尤其 GPT-3 已经展现出惊人的文本生成和理解能力,开始引发业界广泛关注。

2021 年,基于 GPT-3 的 GitHub Copilot 发布,成为第一个大规模落地的生成式 AI 产品,预示着一场生产力革命的到来。

Anthropic 的诞生

OpenAI 与微软的深度绑定及其向「利润上限」模式的转变,虽然解决了生存问题,但也导致了其内部关于 AI 安全和商业化路径的深刻分歧。

这种紧张关系在 2020 年底达到了顶点。时任 OpenAI 研究副总裁、同样出身 Google Brain 的 Dario Amodei,对他所认为的公司日益增长的商业化倾向和对安全问题的忽视感到越发不安。

2021 年初,Dario Amodei 带领一批 OpenAI 的核心研究人员集体出走,创立了Anthropic。这家新公司明确将「AI 安全」置于首位,并以开发「合宪 AI」(Constitutional AI)的独特方法论而闻名,并且 Anthropic 确实至今一直在发表 AI 安全相关的博客文章。

Anthropic 随后获得了 Google 等公司的投资,成为 AI 领域不可忽视的新力量,其产品 Claude 也成为 ChatGPT 和 Gemini 的主要竞争对手之一。

Anthropic 的成立,不仅标志着 AI 顶尖人才的再次分流,也正式开启了 AI 领域关于发展路径(追求能力 vs 确保安全)的「路线之争」。

ChatGPT 横空出世

2022 年 11 月 30 日,一个看似普通的研究预览发布,却意外地点燃了全球对生成式 AI 的热情。

OpenAI 推出了基于 GPT-3.5 模型的聊天界面:ChatGPT。原本只是内部为了测试模型能力、或是为了赶在竞争对手 Anthropic 发布类似产品前推出的一个简单应用,却凭借其流畅自然的对话体验和强大的通用能力迅速引爆网络。一周用户破百万,两个月破亿,ChatGPT 成为史上用户增长最快的消费级应用,其品牌名几乎成了 AI 聊天的代名词。

ChatGPT 的巨大成功,震醒了沉睡的巨人 Google。Google 高层迅速意识到,这种直接提供答案的交互模式,对其赖以生存的核心搜索业务构成了直接的、生存级别的威胁。

2022 年 12 月,CEO Sundar Pichai 在公司内部拉响了「Code Red」(红色警报)。这意味着 Google 必须将 AI 从过去十年作为「维持性创新」来改进现有产品的策略,紧急调整为应对「颠覆性创新」的战时状态。

让局势更加严峻的是,微软迅速抓住了机会。2023 年初,微软宣布向 OpenAI 追加 100 亿美元投资,并高调发布了由 OpenAI 技术驱动的新版 Bing 搜索引擎和 Edge 浏览器。

Satya Nadella 公开宣称:「搜索的新时代从今天开始……我们要让 Google 跳舞」。Google 最强大的老对手,借助其「盟友」的颠覆性技术,卷土重来,直指 Google 的心脏地带。

此时,Google 内部并非没有类似的技术储备。Noam Shazeer 早在离开前就曾开发过一个名为 Mina 的内部聊天机器人,后来演变为 LaMDA 模型。

然而,出于对安全性、准确性、品牌声誉风险的担忧,以及更深层次的商业模式冲突(AI 直接给答案会减少用户点击广告的机会,动摇搜索广告这一现金牛业务)和潜在的法律风险等多重因素考量,Google 一直未能将这些内部原型产品推向大众市场。

相比之下,OpenAI 作为挑战者,没有这些历史包袱,可以选择「快速行动,打破陈规」。

All in Gemini

面对内忧外患,Google 的初步反击显得有些仓促。

2023 年 2 月,Google 匆忙推出了基于 LaMDA 模型的聊天机器人 Bard。然而,Bard 在发布演示中就出现了事实性错误,导致 Google 股价大跌。随后的用户体验也普遍反映 Bard 的能力明显落后于同期基于 GPT-3.5 乃至后续 GPT-4 的 ChatGPT。

这次挫折促使 Sundar Pichai 下定决心进行大刀阔斧的改革。2023 年中,他做出了两个关键决定:

合并 Google Brain 和 DeepMind:结束内部两大 AI 团队长期并立甚至有所内耗的局面,组建统一的 Google DeepMind 部门,由 Demis Hassabis 全权领导。这意味着打破了收购 DeepMind 时关于其独立性的部分承诺,但也显示了整合力量、聚焦目标的决心。All in Gemini:集中最精英的力量,开发一个单一的、统一的、原生的多模态旗舰模型系列:Gemini。要求 Google 所有产品线都要积极寻找与 Gemini 整合的机会。这既是为了集中资源打造最强模型,也是利用 Google 的生态优势推广 Gemini。

为了确保 Gemini 项目的成功,Google 不惜代价。不仅 Jeff Dean 等原 Google Brain 的核心大将与 DeepMind 团队紧密协作,久未参与一线工作的联合创始人 Sergey Brin 也回归参与模型研发。

同时,Google 斥资数十亿美元与 Noam Shazeer 创立的 Character.AI 达成一项复杂的合作协议,实质上将这位 Transformer 论文的关键作者之一请回,与 Jeff Dean 共同担任 Gemini 项目(特别是下一代模型)的技术负责人。

这一系列雷厉风行的举措迅速见效。从 2023 年底开始,Gemini 系列模型以惊人的速度发布并迭代。如今,Gemini 2.5 Pro已是顶尖模型之一,大家对即将发布的 Gemini 3.0 也充满期待。

Google 逐步将 Gemini 整合进搜索(推出 AI Overviews 功能)、推出独立的 Gemini App 取代 Bard,并在搜索页面尝试引入「AI Mode」。同时,在文生视频(Veo)、文生图(Imagen)、游戏环境生成(Genie)等多模态领域也发布了一系列令人瞩目的技术。

此外,Google DeepMind 在 AI for science 领域取得重大突破。其AlphaFold 2系统在 2020 年高精度地预测了蛋白质的三维空间结构,解决了困扰生物学界半个世纪的「蛋白质折叠问题」,对生命科学与新药研发具有深远意义。

基于此项贡献,AlphaFold 2 核心开发者 Demis Hassabis、John Jumper 与计算蛋白设计先驱 David Baker 共同获得了2024 年诺贝尔化学奖,以表彰其革命性贡献。

结语

纵观 AI 发展的波澜壮阔,巨头们在开疆拓土的同时,也背负上了各自沉重的「包袱」。

谷歌手握最好的牌,提出一系列开创性工作,但又受大公司体制的束缚,一度将王牌拱手让人;OpenAI 从最初的理想国,到一度分崩离析,再到今天成为最具实力的玩家之一;Meta 曾稳坐开源王座,如今也不得不在军备竞赛与成本效益的平衡中艰难变革。

与此同时,中国 AI 力量也异军突起。DeepSeek 一夜成名,Qwen 成为新的「源神」,Seed、Kimi 等奋力追赶,抢占高地;即梦、可灵等则在多模B态的新战场上攻城略地。

浪潮之巅,没有永远的王者。 巨头今日的霸权,随时可能被自身的沉疴所拖垮;后起之秀的威胁,也从未像今天这般迫近。

但无论如何,这场激烈的竞争,连同背后无数科学家的执着探索,正汇聚成一股推动历史进程的强大合力,带领人类走向那个充满未知但值得期待的未来。

京公网安备 11011402013531号

京公网安备 11011402013531号