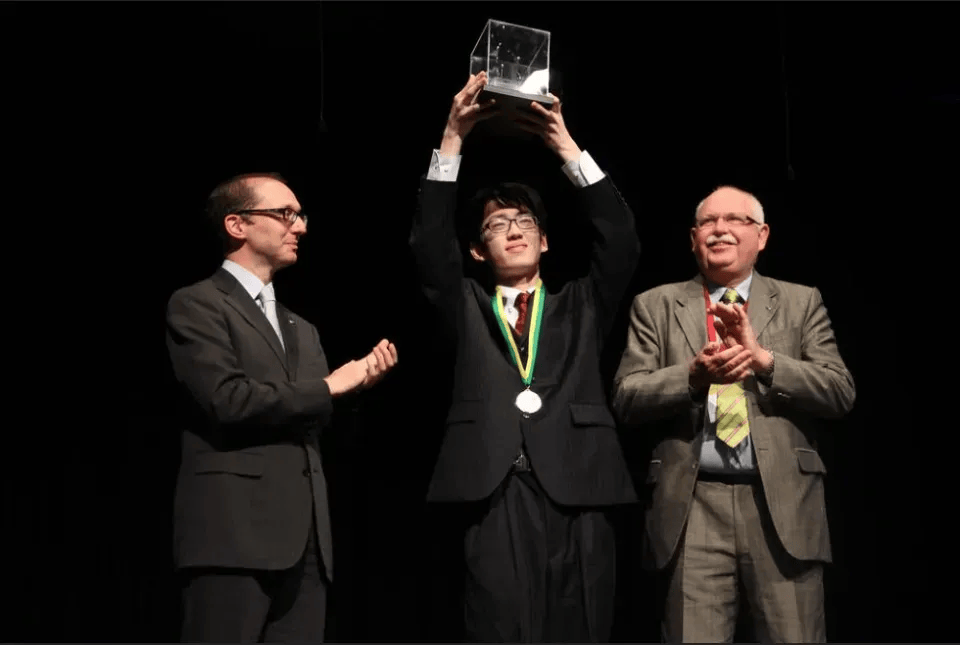

论文第一作者何浩然是香港科技大学博士生,研究方向包括强化学习和基础模型等,研究目标是通过经验和奖励激发超级智能。共同第一作者叶语霄是香港科技大学一年级博士。通讯作者为香港科技大学电子及计算机工程系、计算机科学与工程系助理教授潘玲。

在大语言模型(LLM)的数学推理任务中,基于可验证奖励的强化学习(RLVR)已成为提升模型推理能力的重要手段。然而,主流方法如 PPO、GRPO 等仍然依赖为传统 RL 场景设计的策略梯度更新的学习目标,本质上可以被策略迭代(policy improvement)刻画,即包含策略评估(policy evaluation)与策略改进(policy improvement)的不断循环的过程。这些方法常常面临训练不稳定、多样性丧失、调参复杂等问题。

那么对于 LLM 推理任务,有没有一种更简洁、更本质的解法?

香港科技大学联合阶跃以及快手等团队提出了一个令人惊讶的答案:只需对一个完全随机的策略进行价值评估,就足以找到最优推理路径。他们由此提出 ROVER(Random Policy Valuation for Diverse Reasoning)以极简思路颠覆传统范式,跳过传统强化学习推理的策略迭代(policy improvement)循环。

ROVER 不仅在多项数学推理基准上显著超越现有方法,更以「极简主义」实现高质量与高多样性兼备的推理生成。

目前,论文、代码以及模型均已开源。

论文地址:https://arxiv.org/abs/2509.24981论文代码: https://github.com/tinnerhrhe/ROVER

在 AIME24、AIME25 以及 HMMT25 等高难度任务上,ROVER 相比于传统方法大幅提高了 pass@1(+8.2)和 pass@256(+16.8),并且在多种多样性指标上均达到了新的高度(+17.6%)。并且 ROVER 不需要额外维护价值网络(value network),也不需要维护基模型(reference model)计算 KL,从而更加轻量。

传统强化学习的「痛点困局」:迭代复杂,代价高昂

在 LLM 推理优化中,主流方法(如 PPO、GRPO)可以被广义策略迭代(Generalized Policy Iteration)刻画 —— 反复执行「策略评估(计算当前策略价值,如估计优势函数 advantage)」与「策略改进(更新策略 [数学公式])」。尽管这些方法能提升性能,却存在核心痛点:

训练稳定性差:优化目标「非定常」,模型易崩溃。最近的工作通过叠加复杂技巧如 KL 正则约束、裁剪重要性采样、熵监控等。这些「补丁」让训练如履薄冰,稍有不慎就会引发「熵坍塌」(策略多样性骤降,陷入单一推理路径)。PPO 需维护独立的价值网络预测状态价值,并反复执行策略迭代:GRPO 等方法也需要维护基模型(reference model)计算 KL。这种「重资产」模式,加重了 RL 优化的计算开销。推理多样性流失:为质量牺牲探索,pass@k 性能饱和。基于奖励最大化的传统强化学习方法会使模型过度追求单次推理正确率,牺牲了策略探索能力 —— 模型只会生成少数几种推理路径,牺牲了 pass@k(多次推理覆盖更多可行解的能力)。

ROVER 的「极简革命」:随机策略的 Q 值足以指导最优决策

研究团队首先指出,大语言模型推理任务可被建模为有限时域马尔可夫决策过程(MDP),具备以下关键特性:

确定性状态转移;树状结构(每个状态有唯一父节点,不存在不相交子树);二元稀疏奖励(正确 / 错误)。

这与传统 RL 任务(如 Atari 游戏、机器人控制)中常见的随机性状态转移、循环图结构、中间奖励等复杂设定截然不同。

「我们是否在用过于复杂的工具,解决一个结构上更简单的问题?」—— 这成为 ROVER 研究的出发点。

在这一简单结构中,研究团队证明了一个颠覆性结论:均匀随机策略的 Q 值,直接指向最优策略。

因此,策略学习过程可以简化为下图形式。

ROVER 算法流程:三步极简,免去迭代

(1)Q 值估计:

(2)策略构建:

(3)训练目标:

在实际实现中,ROVER 还引入了:

这种「自监督」式参数化,让模型学习「相对改进」而非「绝对价值」,既减少计算量,又提升稳定性。

ROVER 的损失函数可以表示为

算法伪代码如下

实验结果:全面领先,多样性显著提升

研究团队在数学推理基准(AIME24/25、HMMT25、AMC、MATH 等)、Countdown 任务以及 O.O.D. 任务 GPQA-diamond 上验证 ROVER,覆盖 Qwen3-8B/4B、DeepSeek-R1-1.5B 等模型,结果堪称「降维打击」:

1. 数学竞赛任务:pass@1 与 pass@k 双突破

在 Qwen3-8B-Base 模型上,ROVER 的 pass@1 在 AIME24 达 30.6(比最佳基线 DAPO 高 19.1 分);在 HMMT25 任务中,pass@1 从基线最高 7.1 跃升至 14.6(提升 106%)。

更关键的是 pass@k 性能:传统 RL 方法(如 GRPO)的 pass@k 随 k 增大迅速饱和,而ROVER 在 pass@256 上也能与基线拉开明显差距,展现持续探索能力。

2. 策略多样性:比基线高 17.6%,覆盖更多解题路径

采用 LLM-as-Judge 方法评判所有方法生成的正确答案的推理内容多样性,ROVER 训练的策略多样性比基线平均提升 +17.6%,在 AIME24 上发现更多独特解题路径。在其他多样性指标如余弦距离(cosine distance)与利用率(utility)等,ROVER 在不同温度下仍表现出一致的高多样性。

受益于多样性的提升,ROVER 在 GPQA-diamond 等与数学无关的 O.O.D 任务上也表现最佳。

3. 案例展示:ROVER 发现全新解法

通过「策略数量」指标(同一问题生成的不同推理路径数)评估,ROVER 在各个任务上均能发现更多的解题策略。如下图所示,在「2x3 网格数字排列」问题中,基模型与 GRPO 均仅发现 2 种策略,而 ROVER 可以发现 4 种(包括「隔板法」「容斥原理」等不同数学工具)。

启示与展望

ROVER 的提出,不仅是一次技术突破,更是一次方法论的反思:在某些结构化任务中,简化而非复杂化,才是推进性能的关键。「Simplicity is the ultimate sophistication.」 —— ROVER 这一基于简单随机策略的新方法,诠释了达芬奇这句名言在 AI 时代的新内涵。

更多方法细节与实验分析请见原论文。

京公网安备 11011402013531号

京公网安备 11011402013531号